Elettronica

Enciclopedia delle scienze sociali (1993)

Elettronica

Definizione di elettronica

L'elettronica è la tecnica che permette di manipolare gli elettroni (le particelle dell'atomo che hanno carica negativa) in modo da ottenere una serie di prestazioni: amplificare segnali, captare onde radio, misurare grandezze fisiche (pressione, calore, ecc.), controllare il funzionamento di una macchina, effettuare calcoli, e può pertanto essere definita come "l'utilizzazione delle correnti deboli per identificare, trasmettere, memorizzare o trattare un segnale". Quando la scienza degli elettroni incontra quella delle onde si apre l'universo delle telecomunicazioni, dal telefono alla televisione, dalla radio al radar. Si parla di telematica per indicare l'acquisizione, elaborazione, memorizzazione e distribuzione di informazioni vocali, visive, testuali e numeriche per mezzo di un sistema formato da calcolatori e mezzi di comunicazione. Si parla invece di optoelettronica se ci si riferisce alla tecnologia che sfrutta l'impiego combinato di tecniche ottiche ed elettroniche per la trasmissione e l'analisi di segnali luminosi derivati da segnali elettrici.

Le direzioni dell'innovazione elettronica

È internazionalmente accettata la suddivisione dell'elettronica in cinque generazioni a partire dall'inizio di questo secolo. La prima generazione è quella delle valvole sotto vuoto, realizzate nel 1904 da John Ambrose Fleming nei laboratori dello University College di Londra, utilizzando le scoperte di Edison. La seconda generazione si apre nel 1947 nei laboratori Bell della AT&T negli Stati Uniti con l'invenzione (da parte di John Bardeen, Walter Brattain e William Shocley) del primo transistor, che utilizza le proprietà di alcuni particolari solidi come il silicio. La terza generazione inizia nel 1958 con il primo circuito integrato, realizzato da Jack Saint Clair Kilby nei laboratori della Texas Instruments, che consente di raggruppare e interconnettere su una piccola scaglia (chip) di silicio (e poi di arseniuro di gallio) centinaia e successivamente migliaia di componenti. Quindi la quarta generazione: nel 1971 è costruito, sempre in un'impresa statunitense (la Intel), con il contributo di più competenze (tra cui quella del fisico italiano Federico Faggin), il primo microprocessore. Il microprocessore è un vero e proprio piccolissimo elaboratore fissato su una piastrina di pochi millimetri quadrati. Da tener presente che il periodo che passa tra un'innovazione radicale e l'altra tende a ridursi: la prima generazione dura quasi cinquant'anni, le altre durano al massimo una diecina di anni.

Queste successive innovazioni hanno portato a un processo di crescente miniaturizzazione, aumento delle prestazioni e riduzione progressiva dei costi dei componenti: ad esempio, mentre l'Eniac, uno dei primi calcolatori costruiti con valvole sotto vuoto, conteneva 18.000 valvole, pesava trenta tonnellate e le diverse parti occupavano 180 metri quadrati, oggi è possibile avere a prezzi accessibili calcolatori sempre più piccoli e mobili, dai laptop (da tenere sulle ginocchia) ai palmtop (da tenere in mano).

L'orizzonte dell'innovazione elettronica si amplia quindi straordinariamente con il trattamento di immagini e suoni multimediali, con lo sviluppo delle comunicazioni attraverso i satelliti e le fibre ottiche, con le applicazioni dell'intelligenza artificiale e delle reti neurali, con la fuzzy logic, con l'olografia tridimensionale e la realtà virtuale, con le possibilità aperte dai superconduttori, ecc.

Nel 1982 il MITI (il Ministero dell'industria e del commercio internazionale del Giappone) presenta il Progetto per i sistemi informatici di quinta generazione, e progetti analoghi sono presentati in Europa (il progetto Esprit) e negli Stati Uniti (progetti della DARPA e della MCC). Si inizia così a parlare negli anni ottanta e novanta di quinta generazione dell'elettronica, riferendosi non tanto a cambiamenti nei componenti di base (anche se si sono realizzati i fuzzy chips e i chips neurali e si continua a fare ricerca sui super.conduttori), ma a un modo diverso di programmare le macchine: la sfida è quella di costruire 'macchine intelligenti'.

Le macchine dell'intelligenza artificiale

Il termine 'intelligenza artificiale' (v. McCorduck, 1979) è utilizzato per la prima volta in un convegno tenuto a Dartmouth nel 1956, patrocinato dalla fondazione Rockefeller e coordinato da Marvin Minski, Claude Shannon e John McCarthy (a cui si attribuisce l'introduzione del termine).Punti di riferimento delle macchine costruite in base a principî di intelligenza artificiale sono le riflessioni e le applicazioni del matematico inglese di origine ungherese Alan Mathison Turing (v. Hodges, 1983) che, dopo aver costruito nel 1943 la macchina Colossus per decodificare in Gran Bretagna i codici segreti delle forze armate tedesche, si occupa nel dopoguerra di intelligenza artificiale proponendo una definizione di 'intelligenza' basata sul test di Turing (la macchina è 'intelligente' se il suo comportamento può essere confuso con quello di una persona). I primi programmi di intelligenza artificiale, progettati nel 1956 e 1957 da A. Newell, J.C. Show e H.A. Simon presso la Rand Corporation e il Carnegie Institute of Technology (il Logic Theorist e il General Problem Solver) affrontano l''ntelligenza' come procedimento per la soluzione di problemi, come giocare a scacchi, ecc.

I limiti, e i relativi insuccessi, di questa prima fase sono dovuti, secondo il filosofo Hubert Dreyfus (v., 1972), al fatto che con questi programmi di simulazione cognitiva non si è riusciti a incorporare nei sistemi alcuni elementi essenziali della cognizione umana. Quando una persona risolve dei problemi si concentra su di un punto, ma mantiene una consapevolezza più o meno sfumata su ciò che è intorno a quel punto, e se nota qualche cosa di importante ai confini della propria coscienza (fringes of consciousness) concentra su di essa l'attenzione. Si può ad esempio individuare il volto di una persona conosciuta tra la folla, mentre per il calcolatore un'operazione di questo tipo è difficilissima, perché non ha una sensibilità al contesto e a ciò che avviene in un ampio campo di azione.

Una seconda fase dell'intelligenza artificiale inizia alla metà degli anni sessanta ed è rappresentata da progetti come quelli di Marvin Minsky e Seymour Papert al MIT (v. Bernstein, 1978 e 1982), che restringono l'ambito di applicazione ad alcuni micromondi definiti. Un programma tipico di questa seconda fase è quello progettato da Terry Winograd con il nome Shrdlu (si tratta di sei lettere che occupano dalla settima alla dodicesima posizione tra le lettere più frequenti dell'alfabeto inglese), che porta a un dialogo in linguaggio naturale su di un universo molto ristretto fatto di oggetti tridimensionali poggiati su di un unico piano (si può impartire l'ordine "poggia la piramide rossa sul cubo" e il programma esegue il comando). Questi esperimenti mostrano le possibilità di applicazione dei sistemi esperti a problemi delimitati, ma, come sottolinea Dreyfus, tali sistemi non si prestano ad essere applicati al mondo della vita quotidiana.Inizia così, verso metà degli anni settanta, una terza fase di studi, esemplificabile con le realizzazioni di Roger Schank nell'Università di Yale e di Terry Winograd nell'Università di Stanford. Schank sviluppa l'approccio della così detta 'dipendenza concettuale', in cui l'attenzione al linguaggio naturale è più sul livello semantico che su quello sintattico al fine di consentire al programma di interpretare dei testi: per capire il linguaggio naturale diventa importante individuare i frames (strutture usate per rappresentare classi di azioni), gli scripts (insiemi di conoscenze relative a situazioni stereotipate) e i plans (le mete e i progetti che possono emergere da un testo). Winograd cerca invece di mantenere le formalizzazioni proposte più aperte ai diversi contesti in cui l'evento o l'oggetto può essere descritto. Hubert e Stuart Dreyfus (v., 1988) precisano i limiti di questi programmi: le persone apprendono dall'esperienza e si creano autonomamente le proprie strutture cognitive; queste non sono mai descrivibili formalmente per intero, in quanto c'è un insieme di conoscenze implicite e abilità pratiche basate sulla corporeità, che non potranno mai essere formalizzate in un programma inserito in una macchina.

Un altro filosofo statunitense, John Searle (v., 1984), introduce una distinzione importante tra gli studiosi di intelligenza artificiale: c'è una concezione forte, secondo la quale il pensiero è una manipolazione di simboli formali analoga al modo di procedere del calcolatore (la mente sta al cervello come il programma sta al calcolatore); questa concezione può essere facilmente confutata, perché il calcolatore è in grado di manipolare simboli, ma non vi annette alcun significato. C'è poi una concezione debole, i cui sostenitori non si propongono di definire il pensiero, ma procedono elaborando programmi e chiedono che questi siano valutati per la loro utilità. Questa posizione, più orientata in senso applicativo e ingegneristico, ha portato alla progettazione di sistemi esperti e alla robotica. I sistemi esperti sono sistemi specialistici per cui, in un'area delimitata, il calcolatore riceve informazioni che lo mettono in grado di svolgere funzioni come interpretare, diagnosticare, trasferire conoscenze, fare previsioni, simulare, pianificare, controllare, progettare, ecc. Le applicazioni sono le più diverse e vanno dalla definizione della struttura chimica di composti organici a programmi per l'analisi dei bilanci di impresa. Le critiche che si possono fare ai sistemi esperti (v. Parisi, 1989) sono di due tipi: il primo limite sta nel fatto che questi sistemi posseggono le conoscenze specialistiche di un particolare campo (ad esempio le malattie del fegato o gli investimenti finanziari), ma non dispongono, al di là di queste, del sapere comune che le persone posseggono, e questo li rende molto fragili. Il secondo limite consiste nel fatto che i sistemi esperti utilizzano un approccio simbolico all'intelligenza e ciò fa sì che essi diano risposte in base a un numero di regole previste; una reazione 'intelligente' tiene invece conto del contesto della situazione, senza che si possa programmare o prevedere a priori quale parte del contesto sia rilevante; inoltre, di fronte a un dato nuovo, l'intelligenza naturale non si blocca come invece accade a un sistema esperto.

Più in generale, quando si formulano modelli che simulano comportamenti di tipo decisionale, i rischi sono quelli di non tener conto della complessità interna ed esterna dell'attore che prende decisioni (v. Gallino, 1987).

Sulle tendenze in atto nella robotica, si può dire che essa (v. Tagliasco, 1991) ha attraversato, a partire dal dopoguerra, quattro fasi: una prima fase, durante gli anni cinquanta, in cui si realizzano macchine cibernetiche, per capire i riflessi condizionati, aventi sembianze di piccoli animali, come la tartaruga Cora di W.R. Ashby del 1950; una seconda fase, intorno agli anni sessanta, in cui si diffonde soprattutto la robotica industriale (i robot Unimate installati nelle fabbriche statunitensi e giapponesi) insieme alle prime sperimentazioni di intelligenza artificiale; una terza fase, a partire dagli anni settanta, in cui la robotica esce dalla fabbrica; infine una quarta fase, in cui si ritiene che il robot debba interagire con ambienti non strutturati ed ivi continuare ad apprendere. Si nota il passaggio da una robotica industriale (il robot che compie operazioni di saldatura o verniciatura, che manipola sostanze pericolose nelle centrali atomiche, che posiziona i cavi sottomarini o esegue interventi di manutenzione nelle piattaforme petrolifere) a una robotica più interattiva e di precisione (dai robot programmati per identificare edifici pericolanti e individuare ostacoli, in caso di disastri ambientali, a quelli usati in chirurgia o per aiutare i disabili). I robot dovranno utilizzare sempre di più tutti i sensi (bio-meccatronica) e basarsi maggiormente sull'approccio connessionistico in cui, come scrive Tagliasco, "l'attenzione si concentra sull'apprendimento, il riconoscimento e l'esplorazione interattiva".

Le macchine basate sulle reti neurali

In questo diverso approccio l'obiettivo è quello di riprodurre nelle reti del calcolatore il comportamento delle reti neurali (v. Biondi e altri, 1991). I primi tentativi di tradurre i principî dell'elaborazione biologica in modelli matematici è fatto risalire agli studi pionieristici di Warren S. McCulloch e Walter H. Pitts, che nel 1943 studiarono i neuroni considerandoli alla stregua di dispositivi logici. Negli anni sessanta Frank Rosenblatt, della Cornell University, e Bernard Widrow, della Stanford University, idearono i neuroni attivi: ad esempio il sistema di Widrow denominato Adaline (abbreviazione di elemento adattivo lineare) è un sistema formato da un solo neurone capace di imparare a riconoscere una forma (ad esempio una lettera) indipendentemente dalla sua orientazione e grandezza.Il tipo di struttura che si realizza è una rete di unità interconnesse, dette anche 'nodi' della rete, concepite come unità di elaborazione che, similmente ai neuroni del cervello, operano in parallelo e nel loro operare interagiscono. La rete è addestrata attraverso esemplificazioni e connessioni, in quanto si cerca di trasferire alla macchina una memoria associativa, che le consenta di effettuare riconoscimenti prendendo decisioni collettive, basate sulle connessioni tra più nodi della rete che lavorano simultaneamente. Le differenze rispetto al tradizionale modo di operare di un calcolatore digitale impiegato in una ricerca di intelligenza artificiale cognitivista sono evidenti.

L'approccio connessionistico, così diverso da quello logico sequenziale dell'intelligenza artificiale tradizionale, sta rivoluzionando anche il modo di costruire le macchine per apprendere le lingue e i robot. Ad esempio, la macchina Net talk, costruita dal ricercatore statunitense Terence Sejnowski, del Laboratorio di neurobiologia dell'Università di California a San Diego, è una macchina in grado di leggere, pronunciando correttamente, testi scritti in lingue diverse (macchina utile per persone cieche, persone che non sanno leggere, ecc.)

Il programma per insegnare a leggere a questa macchina è stato elaborato con metodologie connessionistiche attraverso la simulazione di reti neurali: vengono inseriti nella memoria della macchina moltissimi esempi concreti fino a che la macchina si autorganizza ed è in grado, utilizzando la sua memoria di testi letti correttamente, di individuare come va letto il nuovo testo. Nella macchina è perciò formalizzato il modo di apprendere, mentre, a differenza di quanto sarebbe avvenuto nell'approccio tradizionale dell'intelligenza artificiale, non sono fornite alla macchina tutte le possibili e immaginabili regole di pronuncia.

Rodney Brooks del Laboratorio del MIT utilizza la stessa strategia per progettare i suoi robot beings. L'idea base è quella di dotare questi piccoli insetti-robot di un insieme di sensori e di attuatori, che consentono loro di evitare gli ostacoli, avvicinarsi di soppiatto alle persone, camminare su tutti i tipi di terreno, ecc.; anche in questo caso è importante la programmazione dell'apprendimento. Come scrive il biologo Francisco Varela (v., 1991, p. 101), "il futuro dell'intelligenza artificiale è ciò che può essere chiamata vita artificiale", e questo passaggio è possibile solo utilizzando l'approccio connessionista.

La ricerca sulle reti neurali ha portato Federico Faggin, il fisico italiano a cui si deve il primo microprocessore Intel, a realizzare nel 1991 il chip neurale. Questo chip, denominato Synaptics I 1000, può riconoscere qualsiasi scrittura manuale e identificarla, dal momento che è composto di tre parti: una sensoriale, che simula la retina dell'occhio, per catturare l'immagine del carattere; una digitale, per interagire con il sistema informatico; e una in cui si riuniscono le due capacità che caratterizzano il cervello umano: quella intuitiva e quella logica. Al momento Synaptics I 1000 è in grado di riconoscere 20.000 caratteri al secondo con un tasso di errore dello 0,005%.

Queste realizzazioni si intersecano con altri percorsi che hanno come punto di riferimento le reti neurali: i calcolatori ottici neuronici progettati al California Institute of Technology, che hanno la caratteristica di avere una memoria associativa (il calcolatore può riconoscere un'immagine anche se in esso ne viene proiettata solo una parte), o le realizzazioni in computer vision, effettuate da Tomaso Poggio all'interno dell'Artificial Intelligence Laboratory del MIT.

In concomitanza con questo tipo di ricerche sono stati progettati calcolatori paralleli come la Connection machine di W. Daniel Hillis. Questo calcolatore è dotato di 65.536 unità di elaborazione in parallelo, essendo ogni unità in grado di comunicare con ciascun'altra. È evidente la maggiore velocità di queste macchine, che suddividono un problema nelle sue componenti e poi elaborano le componenti in parallelo, rispetto al calcolatore sequenziale tradizionale. Le aree in cui queste macchine connessioniste potranno essere utilizzate sono soprattutto quattro: l'elaborazione di immagini, la simulazione di processi fisici, l'esplorazione di banche dati e l'intelligenza artificiale.

Le applicazioni della fuzzy logic

Un altro percorso di ricerca che mette in discussione un modo tradizionale di considerare le informazioni per risolvere un problema è quello della fuzzy logic (v. Gupta e altri, 1979).

L'ideatore delle prime teorie sulla logica fuzzy è Lofti A. Zadeh che, nel 1962, quando era docente presso l'Università di Berkeley, presentò una prima memoria sulla teoria degli insiemi fuzzy (il termine fuzzy significa 'indistinto', 'non chiaro'). Zadeh osservò che la logica binaria non consente di manipolare agevolmente concetti come 'abbastanza veloce', 'tiepido', 'abbastanza gradevole', ecc. Tra i due estremi di una valutazione (tra lo zero e l'uno della logica binaria) c'è infatti una zona grigia su cui le persone basano la maggior parte delle loro valutazioni. Si può quindi arrivare a una inferenza di tipo fuzzy che è diversa da quella binaria. Ad esempio, nella logica binaria, se si sa che A=B e si verifica che B=C, si può inferire che A=C; nella logica fuzzy, se si sa che "quando l'acqua è molto calda occorre aggiungere molta acqua fredda" e si verifica che "l'acqua è abbastanza calda", si può inferire che "occorre aggiungere un po' d'acqua fredda".

Occorre quindi rinunciare a postulati di precisione esagerata quando questa non abbia importanza vitale per la soluzione di un problema. È preferibile tener sotto controllo molte variabili (anche se si opera nella loro zona grigia) piuttosto che basare le decisioni su poche variabili verificate con precisione assoluta.

Sono già disponibili sul mercato processori basati su questa nuova logica dei valori intermedi, più potente in quanto più vicina al modo di ragionare delle persone.

Il primo fuzzy chip è stato costruito nel 1988 da Takeshi Yamakawa, docente di informatica all'università di Kukamoto. Questo chip è composto di due parti: la prima parte (denominata rule chip) è in grado di eseguire un milione di calcoli al secondo per giungere a conclusioni corrette in base alla teoria degli insiemi indefiniti di Zadeh; la seconda parte (defuzzier chip) decodifica le conclusioni tratte dalla prima parte in termini del tutto comprensibili.

Le applicazioni basate sulla logica fuzzy sono diffuse soprattutto in Giappone. L'applicazione più nota è quella della metropolitana Nanboku-Sendai, in cui un predictive fuzzy control consente di affrontare fasi come la partenza, l'accelerazione e la frenata in modo tale che i vagoni del treno non subiscano scosse e i passeggeri non abbiano più problemi di perdita di equilibrio anche se non hanno trovato posto a sedere. Le società giapponesi produttrici di apparecchiature fotografiche hanno utilizzato la logica fuzzy per controllare la messa a fuoco automatica e risolvere il problema del tremolio che una persona può imprimere alla macchina fotografica: l'apparecchio confronta la composizione di singole immagini in successione, ne determina la differenza e, in alcune frazioni di secondo, rimette a posto l'immagine. Altre imprese hanno utilizzato la fuzzy logic nelle automobili per il cambio automatico delle marce, nelle lavatrici, nei robot industriali e nei sistemi esperti di diagnosi medica.

Le applicazioni della multimedialità

L'obiettivo di collegare più tipi di comunicazione con le strategie interattive di elaborazione delle informazioni è al centro di un'altra area di applicazioni, che si diffondono negli anni ottanta e novanta e che sono indicate con il termine multimedialità.

La confluenza delle tecnologie audiovisive con quelle informatiche porta all'incontro dei paradigmi della sensorialità e della analogicità con i paradigmi della elaborazione e della interattività. Si ha così che il calcolatore allarga la sua sfera di elaborazione ai suoni e alle immagini, fisse e in movimento, con una sempre maggiore interazione con l'utente; la televisione, da mezzo di comunicazione passivo e isolato, diventa un mezzo connesso con altri media, con cui l'utente può interagire.

Una prima importante tecnologia d'incontro multimediale è rappresentata dai compact disc multimediali (prodotti per la prima volta dall'industria olandese Philips), che vedono oggi impegnate le principali società di elettronica statunitensi, giapponesi ed europee.

Vi sono due tipi principali di cd multimediali, oggetto di innovazione tecnologica ed applicazioni. Il primo è il cd-rom, la cui sigla sta per compact disc read only memory. Si tratta di una tecnologia di memorizzazione digitale che utilizza il laser per leggere informazioni digitalizzate (musica, testo, immagini). Il cd-rom viene letto da un apparecchio collegato direttamente a un calcolatore e si possono così ottenere informazioni di tipo diverso (spezzoni di film, foto, musiche, documenti) tutte inserite in dischi di piccolissime dimensioni. Il cd-i (compact disc interactive) è invece progettato per un lettore collegabile con il televisore, senza bisogno di un calcolatore, per cui, pur arrivando alle stesse prestazioni, si esce da un'utenza di studiosi e ricercatori per un'utilizzazione destinata al grande pubblico.

Da tener presente che un dischetto cd-rom di 12 centimetri di diametro contiene fino a 600 milioni di caratteri. L'editoria elettronica multimediale si presenta quindi con grandi possibilità di espansione, potendo proporre enciclopedie multimediali, trascrizioni di diverse opere che possono essere interrogate su specifiche tematiche, prodotti interattivi pensati per i più diversi utenti, ecc.

Altre tecnologie utilizzabili per la multimedialità sono quelle legate al videotex interattivo (v. Ancelin e Marchand, 1984). Le applicazioni di videotex (che prende il nome di prestel in Gran Bretagna, videotel in Italia, ecc.) consentono di trasmettere e ricevere comunicazioni utilizzando servizi gratuiti o a pagamento (attraverso la bolletta del telefono) con un apparecchio formato da una tastiera e da un video (il minitel). Il sistema videotex permette di trasmettere immagini video lente; se è possibile utilizzare un cablaggio in fibre ottiche le immagini trasmesse possono essere anche in movimento e a colori. In Francia questa tecnologia è molto diffusa per la politica del Ministero delle Telecomunicazioni che, unico in Europa, ha distribuito gratuitamente alle famiglie il minitel, diventato oggi uno strumento tecnico presente nelle case di oltre cinque milioni di famiglie.

L'interazione tra persone, favorita dal minitel, può essere estesa a una pluralità di mezzi di comunicazione. Nel 1992 la Tv Van Gogh di Amburgo ha realizzato un programma multimediale interattivo denominato piazza virtuale, che consente interazioni tra persone che possono utilizzare contemporaneamente quattro media (il fax, il videotelefono, il modem e il telefono), visualizzati in quattro finestre dello schermo televisivo.

Tecnologie più complesse all'interno delle applicazioni di multimedialità sono quelle del trattamento digitale dei suoni e delle immagini, che hanno portato alla costruzione di voci sintetiche e alla computer graphics applicata al cinema. Un'area destinata a innovazioni ancor più spettacolari è poi quella della olografia applicata alla televisione per una visualizzazione tridimensionale in movimento.Tutte queste tecnologie aprono numerose possibilità di cambiamento della didattica, della ricerca scientifica, della formazione professionale, e del modo di utilizzare il tempo libero; punti di riferimento internazionali sono il Media Lab del MIT a Boston (v. Brand, 1987) e l'Institute of System Science di Singapore (v. Waterworth, 1991).

Nel Media Lab, in particolare, è presente un'attenzione critica all'innovazione tecnologica. All'interno di questo laboratorio Seymour Papert (l'inventore del Logo) ritiene, ad esempio, essenziale che la multimedialità non si realizzi solo all'interno del calcolatore. Bambine e bambini devono aver la possibilità di manipolare strutture esterne al calcolatore (simili come forma ai tradizionali blocchetti di Lego) per costruire un percorso di utilizzazione personale all'interno di un'offerta multimediale. È stato così realizzato un exploratorium multimediale, in cui bambine e bambini possono avere interazioni complesse tra di loro (realizzando e inviandosi dei prodotti video). L'exploratorium favorisce l'emergere dei diversi immaginari individuali e collettivi e consente anche di ricreare situazioni che aiutino ad apprezzare la bellezza di forme artistiche. Negroponte ritiene che sia importante rovesciare quella che egli chiama "l'asimmetria della multimedialità", per cui c'è da una parte il calcolatore, che fornisce una grande varietà di suoni, colori e immagini, anche in movimento, e dall'altra l'utente, che può reagire solo meccanicamente ai vari stimoli. Per interagire con il calcolatore l'utente deve poter usare la voce e persino gli occhi (sono infatti allo studio tecniche interattive, dette eye tracking, che permettono al calcolatore di reagire ai movimenti oculari); la ricerca sulla multimedialità interattiva deve dunque tendere ad arricchire anche le modalità d'intervento delle persone (v. Negroponte, 1991).

Riflessioni importanti sono anche quelle relative alla possibilità di avere, in una situazione in cui si è costantemente sommersi da immagini e da notizie, un ascolto della televisione (o più in generale delle informazioni) personalizzato. Questa possibilità (resa concreta dal progetto promosso da Intel, Microsoft e General Instruments per costruire un decodificatore di canali televisivi) porta una persona a preselezionare percorsi di informazione e supplementi di conoscenze.

Ugualmente significative anche le riflessioni che si aprono sulla così detta 'democrazia telematica'. Bill Clinton è il primo presidente statunitense ad aver aperto la Casa Bianca a comunicazioni via calcolatore (con il sistema della posta elettronica) con un passaggio di attenzione dalla broadcasting (informazione diffusa) alla narrowcasting (informazione mirata), in cui viene ricercata l'interazione con aggregati locali e particolari.

Le macchine della realtà virtuale

I percorsi della multimedialità conducono a un'altra importante area di sperimentazione e ricerca, quella della realtà virtuale.

Precursori di sperimentazioni in questa direzione possono essere considerati i primi esperimenti di visione stereoscopica e tridimensionale realizzati negli anni cinquanta in sale cinematografiche dove erano proiettate immagini a 360 gradi intorno agli spettatori; fino ad arrivare, nel 1956, alla macchina inventata da Morton Heilig e diffusa nelle sale giochi statunitensi, detta sensorama: la singola persona si siede davanti a uno schermo e, con gli occhiali che permettono una visione tridimensionale, vede un film che, ad esempio, riproduce una corsa in macchina per le strade di New York; oltre ai tradizionali effetti ottici, prova anche le vibrazioni dell'auto in corsa e sente gli odori della città che sta attraversando. Gli inizi delle attuali sperimentazioni si hanno alla fine degli anni sessanta, con i primi lavori di Myron Krueger (v., 1991) e di Ivan Sutherland. Ad esempio Sutherland, uno dei padri della computer graphics, realizza nel 1969, presso l'Università dello Utah, un visore head-mounted (montato sulla testa), che genera le immagini stereoscopiche di una scena tridimensionale. Le immagini sono proiettate su due minuscoli monitor, uno per ogni occhio, attraverso un'apparecchiatura sospesa al soffitto e allacciata alla testa dell'osservatore. Se si gira la testa, si vede un ambiente grafico tridimensionale: i movimenti della testa sono rilevati dall'apparecchiatura e trasmessi al calcolatore che genera la visione adeguata alla direzione dello sguardo.La spinta decisiva allo sviluppo di queste sperimentazioni è venuta dalle possibili applicazioni in campo militare (simulatori di volo e di combattimento, ecc.).

Tali applicazioni attirano l'attenzione sulla realtà virtuale da parte delle imprese private: nasce così nel 1985 a Redwood City in California, per iniziativa di Tom Zimmerman e Jaron Lanier, la VPL Research, prima società che si occupa esclusivamente di realtà virtuale. Questa società produce per prima guanti e tute con sensori e diffonde commercialmente, nel 1989, il primo sistema con cui due persone possono incontrarsi in un ambiente virtuale.Attualmente operano in questa direzione centri di ricerca e società statunitensi, giapponesi ed europei e le esperienze in realtà virtuale si sono stabilizzate in una situazione tipo. La persona viene dotata di uno speciale casco (che assomiglia a una maschera sub, più ingombrante, e con il vetro sostituito da una superficie scura), che si chiama eyephone (occhio-suono) oppure head-mounted display (se si utilizza il termine di Sutherland), sul cui schermo si osserva il mondo virtuale generato dal calcolatore e proiettato sui minimonitor del visore davanti agli occhi. La persona ha poi un particolare guanto, detto data glove (guanto dati), che permette di tradurre i movimenti della mano in coordinate spaziali che sono trasmesse al calcolatore da un fascio di fibre ottiche; si vede così nel mondo virtuale l'immagine della propria mano in movimento che, comandata da movimenti della mano reale, consente di esplorare il mondo virtuale (potendo afferrare e spostare gli oggetti presenti in questo mondo). Sia il casco che il guanto sono collegati al calcolatore per mezzo di cavi e vi sono progetti per arrivare a collegamenti via onde radio per dare maggiori possibilità di movimento. È evidente che l'esperienza nel mondo virtuale dipende dalla complessità del programma tridimensionale inserito nel calcolatore e quindi dipende dagli sviluppi, attualmente notevolissimi, della grafica computerizzata. Inoltre sono già state predisposte, dalla VPL Research, delle data suits, tute con sensori, che consentono di immergersi totalmente nel mondo virtuale.

Tra le applicazioni già realizzate di realtà virtuale vi sono: l'apprendimento di attività pericolose (pilota di aereo o pilota di formula uno); la simulazione di operazioni chirurgiche; la simulazione di spazi architettonici per verificare nuovi progetti o di arredamenti per farli conoscere ai clienti; la simulazione di mondi del presente o del passato per scopi didattici o di mondi fantastici per gioco; la creazione di mondi immaginari come nuova forma di arte; la possibilità di avere incontri con altre persone in una realtà virtuale.

Quest'ultima è l'esperienza probabilmente più spettacolare: persone lontane nello spazio reale possono incontrarsi in uno spazio virtuale senza più il proprio corpo, ma con la possibilità di avvertire sensazioni rispetto all'altra persona e agli oggetti presenti in quell'ambiente. Il tempo che si passa in queste esperienze ha una sua denominazione: si parla di tempo intensivo per distinguerlo dal tempo cronologico o da quello della memoria avvertibile nel mondo reale.

I luoghi della ricerca e dell'industria elettronica

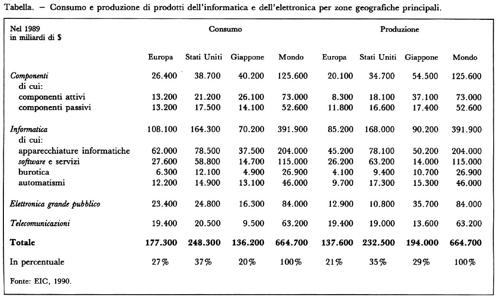

La ricerca per l'innovazione elettronica è oggi concentrata negli Stati Uniti e in Giappone e il consumo e la produzione di prodotti elettronici sono realizzati quasi esclusivamente all'interno della così detta 'triade' (Giappone, Stati Uniti, Europa). Dalla tabella risulta chiaramente che fuori dalla triade si produce e si consuma solo il 15% di prodotti elettronici, anche se la popolazione di questa parte del mondo è sei volte maggiore.

All'interno della triade, dopo una fase di assoluto predominio statunitense durata fino alla metà degli anni settanta, si ha un crescente predominio giapponese. Il Giappone (la cui popolazione è un terzo di quella europea e la metà di quella statunitense) produce il 44% e consuma il 32% dei componenti elettronici immessi sul mercato mondiale, percentuali molto più elevate di quelle statunitensi ed europee.

La produzione giapponese si è poi avvicinata moltissimo a quella statunitense per quanto riguarda la produzione di apparecchiature informatiche, e ha superato gli Stati Uniti nella burotica, cioè nei calcolatori applicati al lavoro d'ufficio. In quanto alla elettronica per il grande pubblico (televisioni, radio, ecc.), il dominio giapponese è totale (la sua produzione copre il 43% del mercato mondiale ed è maggiore di quella delle imprese statunitensi ed europee messe insieme).

Ricerca e industria elettronica negli Stati Uniti

Molte delle imprese che oggi, negli Stati Uniti, operano nel campo dell'elettronica derivano da imprese sorte alla fine dell'Ottocento, fondate da inventori autodidatti o provenienti da laboratori universitari, che, a differenza di quelli europei, dedicano una notevole attenzione allo sviluppo delle imprese industriali.

L'inventore ufficiale del telefono, Alexander Graham Bell, fonda nel 1876 la National Bell Telephone Company, che acquista nel 1883 la Western Electric, prendendo poi, nel 1885, il nome di American Telephone and Telegraph Company (AT&T). La Edison General Electric Company (1889) e la Brusch, Thompson e Huston, che hanno ottenuto capitali per sfruttare le loro invenzioni, danno vita per fusione, nel 1882, alla General Electric.

Analoga è la storia dell'IBM. Nel 1890 i servizi statistici degli Stati Uniti bandiscono un concorso per elaborare i dati del censimento e questo concorso viene vinto da Herman Hollerith, che presenta un suo sistema per inserire dati anagrafici su schede perforate ed elaborarli con una tabulatrice. Hollerith, per soddisfare richieste analoghe, fonda nel 1896 la Tabulating Machine Company che, fondendosi poi con altre ditte dello stesso tipo, porta nel 1911 alla Computing Tabulating e Recording Company che nel 1924 prende il nome di International Business Machines (IBM).

Nella prima metà di questo secolo sia le banche che il governo premono perché si realizzi una concentrazione industriale (anche se una serie di timori porteranno a varare poi leggi anti-trust). Si ritiene che la produzione di massa e la commercializzazione di massa attraverso la formula delle grandi società per azioni siano la strada maestra dell'industria statunitense in generale e di quella elettronica in particolare.

In queste grandi società sono inseriti laboratori di ricerca, che contribuiscono in misura determinante all'innovazione elettronica. Il primo laboratorio di ricerca elettrico-elettronica è quello organizzato nel 1905 alla General Electric, e questo modello sarà ripreso dai laboratori Bell, attivati all'interno della AT&T nel 1925. L'invenzione del transistor avviene proprio in questi laboratori, che possono essere considerati come un inventore collettivo (v. Jacomy, 1990): tra il 1951 e il 1971 i Bell Laboratories hanno al loro attivo il 60% delle innovazioni più importanti nell'area dei semiconduttori. Anche le due successive più importanti innovazioni dell'elettronica avvengono in grandi laboratori dell'industria statunitense: il primo circuito integrato è prodotto dalla Texas Instruments e il primo microprocessore dalla Intel. Nathan Rosenberg (v., 1982), che ha studiato le relazioni tra innovazioni nella ricerca universitaria e innovazioni nei laboratori industriali, sottolinea come negli Stati Uniti, nella produzione di nuovi componenti elettronici e nuovi tipi di software, vi sia non solo un apprendimento per esperienza (learning by doing), tipico della ricerca universitaria, ma anche un apprendimento derivato dall'impiego di un determinato prodotto (learning by using), più diffuso all'interno dei laboratori di ricerca industriali.

La direzione complessiva delle applicazioni elettroniche, per quanto riguarda sia la ricerca universitaria che quella industriale, sarà tuttavia condizionata, negli Stati Uniti, soprattutto dagli apparati statali militari.

I collegamenti tra difesa, ricerca e produzione industriale iniziano durante la prima guerra mondiale e proseguono, prima e durante la seconda guerra mondiale (v. Devereux, 1991), non solo attraverso commesse, ma con la costituzione di laboratori protetti da segreto militare.

Nel clima della 'guerra fredda', in risposta al primo lancio, da parte dei Sovietici, dello Sputnik, nel 1957, vengono costituite nel 1958 la DARPA (Defense Advance Research Projects Agency), la NASA e l'Office of Research and Engineering del Dipartimento della Difesa, con lo scopo di finanziare la ricerca tecnologica di base utilizzabile per scopi militari (sistemi esperti, reti di calcolatori, supercalcolatori). Tra il 1945 e il 1970 il governo federale investe per la difesa una cifra pari a 1.000 miliardi di dollari, il 60% del suo bilancio globale, e, all'interno di questa spesa, viene finanziata anche molta della ricerca e della produzione dell'industria elettronica. L'utilizzazione di fondi del Dipartimento della Difesa per lo sviluppo industriale prosegue anche dopo il 1970. Quando, passata la metà degli anni settanta, gli Stati Uniti si accorgono che l'industria giapponese sta sopravanzandoli, il Dipartimento della Difesa lancia il piano VHSIC (Very High Speed Integrated Circuits) per gli anni 1981-1987, che prevede circa 1 miliardo di dollari per progetti centrati sui circuiti integrati e i microprocessori. Questo piano viene riassorbito nel programma SDI (Strategic Defense Initiative), più noto con il nome di Guerre stellari, con 25 miliardi di dollari stanziati per gli anni 1984-1990.

Il risultato è che negli anni ottanta il 48,7% della ricerca e sviluppo negli Stati Uniti (dati 1987) è finanziato dal governo federale e i due terzi di questa cifra dipendono dal Dipartimento della Difesa e dalla NASA. In Giappone, invece, le imprese contribuiscono per il 73,5% e l'amministrazione pubblica solo per il 19,6%.

La maggior parte della ricerca e della produzione richieste dal Dipartimento della Difesa e dalla NASA alle industrie elettroniche statunitensi è stata di tipo militare e ha avuto scarse ricadute per impieghi civili commercializzabili. Nel complesso l'industria elettronica statunitense si è scarsamente impegnata nelle applicazioni industriali e per il grande pubblico.Per quanto riguarda le applicazioni dell'elettronica ad uso industriale, su di esse ha avuto una grande influenza, come scrive David Noble (v., 1984), l'ideologia taylorista delle macchine automatizzate fool proof ('a prova di scemo'). Questa ideologia, che ha teso a rendere minima la responsabilità del lavoro operaio, ha condizionato sia la ricerca di automazioni flessibili sia l'utilizzo di queste automazioni (la potenziale flessibilità delle macchine a controllo numerico sarà molto meno utilizzata negli Stati Uniti che non in Giappone). Più in generale l'organizzazione del lavoro taylorista nelle produzioni di massa ha costituito l'elemento di crisi del modo di produzione statunitense rispetto al modo di produzione giapponese (v. Womack e altri, 1990).Per quanto riguarda, invece, la produzione di elettronica per il grande pubblico, complessivamente questa produzione è oggi in prevalenza controllata dall'industria e dalla ricerca giapponesi. È però presente, a partire dalla metà degli anni settanta, un tipo d'impresa statunitense innovativa, legata alla creatività di giovani appassionati di elettronica. Nel 1976 due studenti ventenni, Stephen Wozniac e Steven Jobs, fondano la Apple e vendono il primo personal computer, l'Apple 1, al prezzo di 666 dollari. Sempre nel 1976, altri due ventenni, Bill Gates e Paul Allen, fondano la Microsoft che nel 1980 fornisce il linguaggio ai personal computers della IBM.

Queste giovani imprese, come la Apple o la Microsoft hanno un successo economico straordinario: non si tratta soltanto di un successo industriale, ma anche del successo di una nuova cultura che cerca di produrre macchine 'a prova di intelligenza'.

Ricerca e industria elettronica in Giappone

Molto diverso è il contesto in cui hanno inizio la ricerca e l'industria elettronica giapponesi, che si basano su uno stretto rapporto tra apparati dello Stato, grandi complessi industriali e sistema scolastico. Dopo la fine della seconda guerra mondiale il governo giapponese, attraverso il MITI (Ministero dell'industria e del commercio internazionale), sceglie con decisione l'elettronica e l'informatica come industrie portanti con finalità che non sono e non possono essere militari (il trattato di pace impedisce al Giappone la costruzione di armi per l'esportazione e l'orizzonte militare è precluso all'innovazione e alla produzione elettroniche). A differenza di quanto avviene negli Stati Uniti, le applicazioni dell'elettronica saranno in Giappone orientate verso usi industriali e per il grande pubblico. Le tappe che segnano questo percorso sono facilmente ricostruibili. Nel 1952 al MITI viene affiancata l'impresa statale NTT (la Nippon Telephon and Telegraph), sotto la direzione del Ministero delle poste e delle telecomunicazioni, e vengono costituiti due laboratori per la ricerca in elettronica (uno sotto la responsabilità del MITI e uno sotto la responsabilità della NTT). Dal laboratorio della NTT uscirà nel 1953 il primo transistor giapponese.

Nel 1960 viene fatto un accordo tra il MITI e l'IBM per produrre calcolatori e nel 1961 il MITI favorisce un programma di produzione autonoma di calcolatori, che coinvolge due banche e le sei principali industrie elettroniche (Fujitsu, Hitachi, NEC, Toshiba, Mitsubishi e Oki). Negli anni sessanta e settanta viene realizzata una serie di programmi di ricerca e sviluppo con protagonisti il MITI, la NTT, le principali imprese di elettronica e una particolare struttura creata nel 1970: la Information Technology Promotion Agency. Si arriva così al programma più impegnativo, quello del 1982-1992, che si propone di costruire i calcolatori della quinta generazione legati a programmi di intelligenza artificiale (v. Boettcher e Fischer, 1982).Tra le imprese di elettronica giapponesi e quelle statunitensi vi sono numerose differenze. La maggior parte delle imprese giapponesi di elettronica appartiene a gruppi molto ampi (Mitsubishi, Matsushita, Hitachi, Toshiba), che non sono specializzati soltanto in prodotti elettronici e dove, in genere, la produzione di componenti si accompagna a produzioni elettroniche per l'industria e per il grande pubblico. C'è quindi, rispetto alle imprese statunitensi, che sono più specializzate, la possibilità di realizzare maggiori sinergie.

Una seconda importante differenza è il maggiore impegno delle imprese giapponesi nella costruzione del mercato sia per il grande pubblico sia per le industrie. La strategia di creare il mercato dei prodotti elettronici si basa sulla volontà di ampliare il più possibile il consumo interno. Si ha così in Giappone un grande uso di robotica industriale, di apparecchiature elettroniche negli ospedali, di personal computers nelle famiglie e nelle scuole.Inoltre nelle grandi imprese giapponesi è molto diversa l'organizzazione del lavoro. I metodi di Taiichi Ohno, applicati presso la Toyota a partire dal 1949-1950 (per cui si parla di 'toyotismo' contrapposto al 'taylorismo'), sono diffusi anche nelle imprese dell'elettronica.

Il processo di ricerca e sviluppo diventa il centro dell'impresa, come mostrano le analisi di Minoru Ito (v., 1991) su aziende di produzioni elettroniche quale la Oki, e gli interscambi tra chi lavora nella produzione e chi lavora nei laboratori di ricerca sono molto più frequenti di quanto non avvenga nelle imprese statunitensi (v. Weiss, 1985). L'organizzazione della produzione e del lavoro tende in Giappone a una maggiore flessibilità all'interno e all'esterno dell'impresa (v. Piore e Sabel, 1984; v. Friedman, 1988) e i vincoli che sono presenti nelle più grandi imprese giapponesi (come il sistema delle assunzioni a vita e le ore di lavoro molto più numerose che negli Stati Uniti e in Europa) s'intrecciano con quelle elevate flessibilità (v. Dore, 1986).

Nel sistema scolastico giapponese (in cui attualmente il 95% degli studenti arriva al diploma o titolo equivalente) si dà grande importanza all'uso del calcolatore, sia pure a prezzo di una riduzione drastica dei contenuti di materie storiche, sociologiche, filosofiche, ecc., e con un sistematico scoraggiamento della creatività individuale. Questo 'modello educativo tecnocratico' incomincia ora a essere oggetto di critica anche da parte degli ambienti industriali.

Ricerca e industria elettronica in Europa

La ricerca e l'industria elettronica in Europa, se raffrontate con quelle di Stati Uniti e Giappone, sono valutabili molto negativamente. Il giudizio che viene in genere espresso è drastico: "l'Europa, dal punto di vista della ricerca e della produzione elettronica, è fuori gioco" (v. Humbert e Perrault, 1991, p. 149).Nelle nazioni europee è mancata, per contrastare l'iniziale vantaggio statunitense nell'innovazione e nella produzione elettronica (vantaggio aumentato dalle spese del Dipartimento della Difesa e della NASA), la determinazione dello Stato giapponese, che ha scelto l'elettronica come obiettivo strategico.Il limite principale, in Europa, consiste nell'assenza, salvo alcune eccezioni (Philips, Siemens, Bull, Olivetti), di grandi laboratori di ricerca all'interno delle imprese, collegati con laboratori universitari e coordinati da una politica governativa. Queste carenze risultano evidenti se si considera la presenza in Europa dei numerosissimi laboratori di ricerca delle aziende statunitensi e giapponesi di elettronica e, per contro, la limitata presenza di laboratori di ricerca di aziende europee in Giappone e negli Stati Uniti. Il numero totale di ricercatori nell'industria per 10.000 abitanti è di 288 negli Stati Uniti, 229 in Giappone, 175 in Germania, 153 in Gran Bretagna, 88 in Francia e 48 in Italia (dati OCDE, 1987). In valore assoluto il numero dei ricercatori nelle imprese giapponesi è superiore a quello delle quattro nazioni europee indicate.

Di fronte alla complessiva debolezza dell'industria e della ricerca europee (anche se con importanti eccezioni), la CEE ha deciso di intervenire con programmi adeguati, iniziando nel 1982 con Esprit (tecnologie dell'informazione) e proseguendo poi con Race (sviluppo delle telecomunicazioni), Drive (informatica e telecomunicazioni applicate ai trasporti stradali), Delta (tecnologie dell'insegnamento), Aim (informatica avanzata in medicina), Euret (trasporti), BriteEuram (messa a punto di materiali avanzati) fino ad arrivare al programma Eureka. Eureka è stato lanciato dal presidente francese Mitterrand, insieme al cancelliere della Germania Kohl, per rispondere al programma Guerre stellari statunitense e ha rappresentato una svolta importante nella politica europea per il maggior impegno nei confronti della ricerca in elettronica. Un bilancio dei suoi primi cinque anni (1985-1990) porta a individuare 300 progetti per 10.000 miliardi di lire; nella microelettronica è stato realizzato il programma Jessi di 6.000 miliardi di lire per cercare di recuperare almeno in parte il divario nella produzione di microprocessori con il Giappone e gli Stati Uniti; nelle telecomunicazioni è presente il programma Hdtv per una televisione europea ad alta definizione; nei trasporti l'industria automobilistica europea ha portato avanti, con il cofinanziamento della CEE, il progetto Prometeus per costruire l'auto del 2000, studiando in particolar modo i dispositivi di sicurezza; nella robotica è iniziato il progetto Famos per la fabbrica flessibile; per la tutela dell'ambiente sono stati predisposti programmi per definire strategie d'intervento in relazione ai rifiuti industriali e urbani, all'inquinamento da rumori, all'impiego della chimica in agricoltura, ecc.

Inoltre nel 1954 è stato costituito il CERN, organizzazione europea per la ricerca nucleare; nel 1962 l'ESO, osservatorio sudeuropeo per la cooperazione degli studi astronomici; nei primi anni settanta l'Agenzia spaziale europea, che ha portato avanti programmi come la stazione spaziale Columbus, la navetta Hermes, il lanciatore Ariane, il satellite per telecomunicazioni Drs, il satellite per telerilevamenti Ers; nel 1974 il Laboratorio europeo di biologia molecolare.

Per capire lo sviluppo delle nuove tecnologie e i problemi che si presentano alle diverse nazioni europee, nel 1978 è stato costituito dalla CEE il centro studi europeo FAST (Forecasting and Assessment in Science and Technology), che ha già concluso tre articolati programmi di ricerca quadriennali in cui sono stati affrontati non solo problemi tecnologici, ma anche problemi sociali.

Particolarmente significativo è il programma di ricerche su Scienza, tecnologia e coesione della Comunità, la cui sintesi è stata presentata nel 1992. Il punto di partenza di questo programma è la constatazione che le regioni europee differiscono non soltanto per lo sviluppo dell'innovazione tecnologica (in particolare quella elettronica e informatica), ma anche per caratteristiche culturali, sociali e tecniche che potrebbero essere valorizzate per un intreccio diverso tra innovazione tecnologica e innovazione sociale. A una mappa dei punti di eccellenza dello sviluppo tecnologico (formata dalle aree europee in cui sono concentrate le imprese e i centri di ricerca più innovativi) si aggiunge un'altra mappa, in cui i poli di eccellenza sono rappresentati da concrete esperienze di integrazione tra innovazione tecnologica e innovazione sociale. Le due mappe si sovrappongono solo parzialmente (ci può essere, infatti, un uso migliore di tecnologie elettroniche in regioni danesi e olandesi che nelle aree tecnologicamente più avanzate della Francia e della Germania). La lotta alla disuguaglianza tra le regioni europee, dal punto di vista del FAST, non deve solo tendere al raggiungimento, in tutte le zone, di un livello accettabile di sviluppo tecnologico, ma deve anche pervenire a un maggiore equilibrio tra lo sviluppo tecnologico e quello sociale.

Elettronica e società

Elettronica e rapporti tra Stati

La recente guerra del Golfo può essere definita la prima vera 'guerra elettronica' (v. Devereux, 1991), nel senso che è stata preparata e condotta, dagli Stati Uniti, facendo ampio ricorso alle nuove tecnologie dell'elettronica e dell'informatica.

Innanzitutto la regia della guerra è stata definita, sulla base delle informazioni ricevute via satellite, all'interno di un sistema computerizzato di gestione della guerra, un sistema che permette di: a) orientare le decisioni, discriminando, tra le molte informazioni provenienti dai sensori di avvistamento e di sorveglianza in tempo reale, quelle più rilevanti per la battaglia; b) pianificare l'uso delle armi a disposizione; c) impartire gli ordini; d) attuare le decisioni e verificarne gli effetti.

Ogni pilota di caccia ha avuto un addestramento con simulazioni in realtà virtuale e ha potuto utilizzare il Pilot's Associate - un sistema di assistenza con riconoscimento voce e visione in grado di dare informazioni su come comportarsi in battaglia - e un particolare casco che consente di avere informazioni con rappresentazione elettronica.

Da tener presente che i vari Patriot, Tomhawk, ecc. non si sarebbero potuti realizzare senza la specializzata componentistica giapponese e che un giorno di guerra del Golfo è costato 600 milioni di dollari.

La guerra diventa sempre di più un'impresa tecnologica molto costosa e la 'guerra elettronica' presenta problemi politici diversi rispetto alle guerre tradizionali. In particolare la rapidità dei combattimenti richiede altrettanta rapidità di decisioni e lascia alle autorità politiche un tempo minimo, se non nullo, per considerare alternative non militari (v. Simoncini, 1992).

Elettronica, lavoro e occupazione

Quando, negli anni settanta, s'iniziò a valutare gli effetti sull'occupazione di quella che veniva ormai definita la 'rivoluzione elettronica', le previsioni che venivano fatte in rapporti come quello di Simon Nora e Alain Minc (v., 1978) erano complessivamente pessimistiche per ciò che riguardava il numero degli occupati e ottimistiche per quel che concerneva l'incremento della professionalità portato dalle nuove tecnologie.

Furono previste due conseguenze: a) una caduta consistente dell'occupazione per l'introduzione della microelettronica nel lavoro di fabbrica (un esempio è quello della Olivetti, dove il passaggio dalla calcolatrice elettromeccanica Divisumma alla Logos 40 elettronica ha comportato una riduzione del tempo di lavoro per macchina da 9 ore e 10 minuti a 50 minuti) e per l'automazione negli uffici (in Francia ci si interroga sul futuro di quello che viene chiamato l''esercito delle 800.000 segretarie'); b) una maggiore professionalizzazione per effetto dell'introduzione delle nuove tecnologie nelle fabbriche e negli uffici, che portano ad aumentare le conoscenze precedenti e a rendere più complessi i lavori.A distanza di venti anni ci si può chiedere quali di queste previsioni si siano realizzate, tenendo presente che lo scenario occupazionale dei primi anni novanta vede la disoccupazione in aumento negli Stati Uniti e in Europa, dopo la sua riduzione avvenuta a partire dalla metà degli anni ottanta.

Per quanto riguarda il timore di una caduta di occupazione complessiva per effetto del progresso tecnologico, si è in effetti verificata negli Stati Uniti, in Europa e anche in Giappone una riduzione del numero degli operai, causata dall'introduzione della microelettronica, in industrie come quelle dell'auto, dei televisori e dei calcolatori; anche negli uffici, per effetto dell'introduzione di nuove tecnologie, sono avvenute riduzioni dell'occupazione, o si prevede che avvengano.

La rivoluzione elettronica ha però incrementato l'occupazione in altri settori. Rapporti redatti alla metà degli anni ottanta, negli Stati Uniti (v. Hartman e altri, 1986) e in Europa (v. Olerup e altri, 1985), sottolineano come la rivoluzione elettronica abbia anche creato nuovi posti di lavoro. In alcune banche e società di assicurazioni, ad esempio, la riduzione del numero degli addetti, dovuta all'introduzione dell'office automation, è stata compensata dall'aumento della gamma dei servizi che quelle banche e quelle società di assicurazioni offrono, anche grazie all'introduzione dell'elettronica (servizi legati alle carte magnetiche, alle polizze multiuso, ecc.). L'occupazione è inoltre aumentata nel terziario (servizi alle imprese e alle persone) grazie, soprattutto, all'innovazione tecnologica.

Nei rapporti internazionali sull'occupazione, come quelli annuali della CEE, si è quindi cessato di fare previsioni generali sulle conseguenze dell'innovazione elettronica sull'occupazione, ma vengono indicati soltanto effetti circoscritti, negativi o positivi a seconda dell'area di attività considerata.

Si può affermare, comunque, che le previsioni pessimistiche di un crollo complessivo dell'occupazione, per effetto del mutamento tecnologico, non si sono realizzate, perché, all'interno di una situazione occupazionale mutata, il terziario avanzato ha assorbito l'eccesso di manodopera di altri settori.

Non si sono però realizzate nemmeno le previsioni ottimistiche sull'aumento di professionalità. Come sintetizza Tom Forester (v., 1985 e 1987), negli Stati Uniti c'è stato un aumento percentuale molto alto delle occupazioni più strettamente legate alle nuove tecnologie, ma si tratta, per la maggior parte, di attività dequalificate o poco qualificate, svolte nel settore terziario. Inoltre è molto aumentata negli Stati Uniti e in Europa l'area dei lavori precari, a tempo parziale, a termine, ecc., che interessano soprattutto le nuove generazioni, le quali si presentano sul mercato del lavoro con livelli d'istruzione molto elevati.

C'è infine da segnalare che le nuove tecnologie hanno ridisegnato molte delle precedenti attività professionali e i criteri di valorizzazione (sul piano delle qualifiche e dei compensi) di questi cambiamenti sono oggi, negli Stati Uniti e in Europa, oggetto di dibattito.

Elettronica e vita quotidiana

Le potenzialità dell'innovazione elettronica sono elevatissime, non solo per usi bellici e militari ma anche per usi pacifici e civili. Le applicazioni in campo civile iniziano ad essere diffuse tra il grande pubblico (la carta bancomat, il videoregistratore, il fax, il personal computer, ecc.).

Se si considerano le possibilità della 'casa elettronica' (o 'domotronica'), si può osservare che la vita quotidiana nelle case cambia o potrebbe cambiare notevolmente. Ci sono cambiamenti in tutte queste aree: studio (poter studiare a casa programmi in open learning o di formazione a distanza con tecniche multimediali); tutela della salute (possibilità di avvisare una struttura esterna con il teleallarme, di avere diagnosi attraverso il cardiotelefono, di avere una dialisi a domicilio, ecc.); controllo e gestione della casa (uso del computer per la gestione familiare e la programmazione delle diverse apparecchiature come gli impianti di riscaldamento, i sistemi di allarme, ecc.); lavoro domestico familiare (robotica domestica); possibilità di divertirsi (multimedialità interattiva); possibilità di comunicazione con altre persone (computer con modem, fax, videotel interattivi che consentono incontri con altre persone); possibilità di contatti con altre strutture (collegamento con la propria banca, acquisti per videotel); possibilità di lavoro a casa (telelavoro).

Una ricerca francese, effettuata per la CEE (v. Mercier e altri, 1984), ipotizza che una famiglia sia dotata di tutte queste tecnologie e descrive tre scenari: uno scenario armonioso in cui tutte queste tecnologie elettroniche aiutano ad avere una vita più intensa e serena; uno scenario di totale disfunzionalità, per cui queste tecnologie finiscono per creare tensioni e difficoltà tra i componenti della famiglia; infine uno scenario di totale dipendenza tecnologica, in cui la vita quotidiana di ciascun componente finisce con il ruotare continuamente intorno a queste novità tecnologiche, che assorbono totalmente ogni altra attività al di fuori dello studio e del lavoro. Quindi, anche se fosse possibile dotare tutte le famiglie di queste costosissime innovazioni elettroniche, il risultato finale potrebbe non andare nella direzione dello scenario armonioso, ma creare inutili disfunzionalità o pericolosi condizionamenti.

Le relazioni tra tecnologie legate all'innovazione elettronica e vita quotidiana sono al centro di un'altra ricerca italo-francese effettuata per la CEE (v. Capecchi e altri, 1987). Da questa ricerca risulta evidente che, se si esamina la vita quotidiana, l'innovazione tecnologica non può essere considerata valida in sé; perché produca dei vantaggi è necessario che si accompagni a innovazioni sociali, intendendo con questo termine la valorizzazione delle 'capacità fondamentali' delle persone: capacità di realizzare i propri progetti, di interagire con altre persone, di massimizzare la propria autonomia, ecc. La ricerca mostra che, considerando le principali applicazioni dell'innovazione elettronico-informatica a vari ambiti della vita quotidiana (vita familiare, vita sociale, vita scolastica, cura della propria salute, ecc.) in sei nazioni europee, la relazione tra innovazione tecnologica e innovazione sociale può assumere modalità diverse.

Una modalità, molto diffusa, è quella della parzialità fuorviante, che si ha quando una tecnologia elettronica si rivolge, in maniera privilegiata, a un gruppo di potenziali consumatori senza verificare l'insieme di necessità (tecnologiche, economiche, sociali, strutturali, ecc.) di cui quel particolare aggregato di persone può aver bisogno. Un'apparecchiatura come il teleallarme, che consente a una persona anziana di avvisare altre persone e strutture sanitarie esterne premendo una tasto di un dispositivo trasmittente, può produrre effetti negativi (ad esempio deresponsabilizzazione dei familiari e quindi maggior isolamento sociale della persona), se non è inserita in un sistema molto più ampio di assistenza domiciliare, che cerchi (utilizzando tutte le possibili tecnologie e innovazioni sociali) di agevolare l'autonomia e le capacità di interazione delle diverse persone anziane.

Sperimentazioni più riuscite di integrazione tra innovazioni tecnologiche e innovazioni sociali si hanno quando l'innovazione tecnologica risponde a un reale bisogno sociale o si integra in un progetto di valorizzazione delle capacità fondamentali delle persone. Sono pertanto positivi alcuni tipi di didattica che utilizzano le nuove tecnologie (v. Turkle, 1984), l'uso di particolari linguaggi come il Logo, che possono consentire a persone con handicap di esprimersi, la diffusione in Francia del minitel dialogue, che consente a persone sorde di comunicare inviando e ricevendo messaggi scritti in tempo reale attraverso una tastiera del computer, ecc.

La relazione può poi prendere la forma dell'approfondimento o del potenziamento dell'innovazione sociale. La progettazione di una macchina per dialisi a domicilio, o la realizzazione di un programma in open learning, costringe a riflettere sul tipo di attrezzatura tecnica, o di struttura della lezione, che viene utilizzata tradizionalmente in ospedale, o nell'aula.

La relazione tra innovazione tecnologica e innovazione sociale può assumere, infine, un'ulteriore dimensione: l'innovazione tecnologica porta ad evidenziare un problema sociale. Il caso più interessante è quello del minitel in Francia. Tra tutti i servizi a cui si poteva accedere con il minitel quello largamente più utilizzato, soprattutto nei primi anni, è stato il 'dialogo' a distanza, cui i vari interlocutori potevano partecipare inviandosi, tramite una tastiera e uno schermo, messaggi scritti, firmati con uno pseudonimo. Le indagini sociologiche, effettuate in Francia, hanno mostrato che usufruivano di questo servizio persone di sesso maschile, di età tra i trenta e i quarant'anni, che conducevano una normale vita familiare e lavorativa (erano sposati, avevano un lavoro stabile). In questo caso l'innovazione tecnologica ha evidenziato un problema sociale: la solitudine di persone adulte nelle grandi città, che cercano dialoghi in uno spazio telematico per sopperire all'insufficienza dei contatti sociali.

(V. anche Automazione; Informatica; Intelligenza artificiale; Robotica; Telematica).

Bibliografia

Ancelin, C., Marchand, M., Le vidéotex, Paris 1984.

Bernstein, J., Science observed, New York 1978 (tr. it.: Uomini e macchine intelligenti, Milano 1990).

Bernstein, J., Experiencing science, New York 1982.

Biondi, E., Morasso, P., Tagliasco, V. (a cura di), Neuro-scienze e scienze dell'artificiale: dal neurone all'intelligenza, Bologna 1991.

Boettcher, C., Fischer, P., Le Japon et l'informatique, Paris 1982.

Brand, S., Media Lab. Inventing the future in the MIT, New York 1987 (tr. it.: Media Lab, il futuro della comunicazione, Bologna 1993).

Capecchi, V., Pesce, A., Schiray, M., Nouvelles technologies et vie quotidienne, Bruxelles 1987.

Delapierre, M., Zimmermann, J.B., La globalisation de l'industrie des ordinateurs, Bruxelles 1991.

Devereux, T., Messenger gods of battle, London 1991 (tr. it.: La guerra elettronica, Varese 1993).

Dore, R., Flexible rigidities, industrial policy and structural adjustment in the Japanese economy 1970-1980, Stanford 1986.

Dreyfus, H.L., What computers can't do: a critique of artificial reason, New York 1972.

Dreyfus, H.L., Dreyfus, S.E., Making a mind versus modeling the brain: artificial intelligence back at a breakpoint, in "Proceedings of the American Academy of Arts and Sciences", 1988, CXVII, 1.

Forester, T. (a cura di), The information technology revolution, Cambridge 1985.

Forester, T., High-tech society, Cambridge, Mass., 1987.

Friedman, D., The misunderstood miracle, Ithaca, N.Y., 1988.

Gallino, L., L'attore sociale: biologia, cultura e intelligenza artificiale, Torino 1987.

Gupta, M.D., Ragade, R.K., Yager, R.R. (a cura di), Advances in fuzzy set theory and applications, Amsterdam 1979.

Hartman, H.I., Kraut, R.E., Tilly, L.A. (a cura di), Computer chips and paper clips, Washington 1986.

Hodges, A., Alan Turing the enigma, New York 1983 (tr. it.: Storia di un enigma. Vita di Alan Turing 1912-1954, Torino 1991).

Humbert, M., Perrault, J.L., La globalisation de l'industrie electronique, Bruxelles 1991.

Ito, M., Les mouvements du personnel comme vecteur des transferts de technologie e de la compétitivité des entreprises japonaises, in "Sociologie du travail", 1991, XXXII, 1, pp. 105-117.

Jacomy, B., Une histoire des techniques, Paris 1990.

Krueger, M.W., Artificial reality II, New York 1991 (tr. it.: Realtà artificiale, Milano 1992).

McCorduck, P., Machines who think, New York 1979 (tr. it.: Storia della intelligenza artificiale, Padova 1987).

Mercier, P.A., Plassard, F., Scardigli., V., La société digitale, Paris 1984.

Negroponte, N., Intervista a Nicholas Negroponte professor of media technology, in "Multimedia", 1991, 8, pp. 9-14.

Noble, D.F., America by design. Science, technology and the rise of corporate capitalism, New York 1977 (tr. it.: Progettare l'America. La scienza, la tecnologia e la nascita del capitalismo monopolistico, Torino 1978).

Noble, D.F., Forces of production, a social history of industrial automation, New York 1984.

Nora, S., Minc, A., L'informatisation de la société, Paris 1978 (tr. it.: Convivere con il calcolatore, Milano 1979).

Olerup, A., Schneider, I., Monod, E. (a cura di), Women, work and computerization, opportunities and disadvantages, Amsterdam 1985.

Parisi, D., Intervista sulle reti neurali, Bologna 1989.

Piore, M.J., Sabel, C.F., The second industrial divide, New York 1984 (tr. it.: Le due vie dello sviluppo industriale, Torino 1987).

Poullot, D., D'Artois, O., La globalisation dans le telecommunications, Bruxelles 1991.

Rosenberg, N., Inside the black box: technology and economics, Cambridge 1982 (tr. it.: Dentro la scatola nera: tecnologia ed economia, Bologna 1991).

Searle, J.R., Mind, brain and science, Cambridge 1984 (tr. it.: Mente, cervello, intelligenza, Milano 1988).

Simoncini, L., Guerre troppo intelligenti, in "Sapere", 1992, IV, pp. 43-55.

Tagliasco, V., Le quattro epoche del robot, in "Media duemila", 1991, IX, 8, pp. 36-40.

Turkle, S., The second self, New York 1984 (tr. it.: Il secondo io, Milano 1985).

Varela, F., Penser l'intelligence artificielle: le point de vue d'un biologiste, in Les nouveaux outils du savoir (a cura di P. Chambat e P. Levy), Paris 1991, pp. 87-101.

Waterworth, J.A. (a cura di), Multimedia, techonology and applications, New York 1991 (tr. it.: Multimedia, tecnologia e applicazioni, Padova 1992).

Weiss, A., L'industrie japonaise, mythes et realité, in "Harvard-L'expansion", estate 1985.

Womack, J.P., Jones, D.T., Roos, D., The machine that changed the world, Cambridge 1990 (tr. it.: La macchina che ha cambiato il mondo, Milano 1991).

© Istituto della Enciclopedia Italiana - Riproduzione riservata