Telecomunicazioni

Enciclopedia della Scienza e della Tecnica (2008)

Telecomunicazioni

Il termine telecomunicazioni indica tradizionalmente l’insieme delle tecniche e dei procedimenti per la comunicazione a distanza di suoni (voce, musica), immagini, testi ecc., ai quali oggi ci si riferisce come segnali, quantità variabili nel tempo e di natura elettromagnetica, acustica o altra ancora, ormai quasi sempre rappresentati in forma numerica (o, più diffusamente, digitale). I segnali sono in grado di veicolare le informazioni da trasmettere, le quali sono generate da un mittente e inviate a uno o più destinatari (telecomunicazioni punto-punto, mono o bidirezionali, o punto-multipunto) o fornite in diffusione (broadcasting) a un numero illimitato di destinatari (come nei comuni servizi di radio e telediffusione). A ciò si affianca sempre più l’acquisizione, a distanza, di informazioni su situazioni esterne, quali l’ambiente naturale (e le sue modifiche dovute all’intervento umano) e il traffico di mezzi mobili (aerei, navali, terrestri). Le discipline classificate sotto il nome di telecomunicazioni possono quindi essere suddivise in due gruppi: le telecomunicazioni nel significato classico sopra accennato, o in senso stretto, e il rilevamento che si caratterizza dalla generazione del contenuto informativo mediante segnali che interagiscono con l’ambiente circostante, o sono da esso stesso generati, e che include le aree del telerilevamento, della sorveglianza e del riconoscimento (con classificazione/identificazione degli oggetti di interesse).

Nei due vasti settori, le metodologie e le teorie (in particolare quelle relative alla sintesi, analisi ed elaborazione deisegnali mono- e pluridimensionali e alla decisione statistica) sono analoghe e, a volte, coincidenti, anche se diverse sono le applicazioni.

Ciò avviene anche in un terzo settore di crescente rilevanza applicativa, quello della radionavigazione, che permette a un utente di governare il proprio percorso grazie ai segnali radioelettrici emessi da infrastrutture fisse o in orbita attorno alla Terra (nel secondo caso si usa il termine navigazione satellitare a volte seguito dall’aggettivo globale).

Un esempio di coesistenza funzionale delle telecomunicazioni in senso stretto con il rilevamento e la navigazione è presente nella gestione del traffico aereo. I sistemi di controllo del traffico aereo, (ATC, Air traffic control) hanno lo scopo digarantire la sicurezza del volo senza pregiudicarne l’economicità e la speditezza. La crescita del traffico aereo (circa il 6% all’anno con valori a due cifre in Oriente) richiede un miglioramento continuo della sicurezza in termini di incidenti per ora di volo (attualmente, dell’ordine dell’unità per dieci milioni di ore) incluse le varie fasi: rullaggio, decollo, salita, volo in aerovia, discesa, atterraggio. Le necessarie separazioni (longitudinale, laterale, verticale) minime tra coppie di aeromobili sono mantenute mediante cooperazione tra i piloti e i controllori del traffico aereo, costantemente in contatto radio. I primi utilizzano il sistema di navigazione a bordo, basato sui radioaiuti terrestri e satellitari e sui navigatori inerziali; i secondi utilizzano i sistemi di sorveglianza dello spazio aereo (radar primari e secondari, multilaterazione, sorveglianza dipendente automatica). Il necessario collegamento tra pilota e controllore sta evolvendo dalla tradizionale radiotelefonia in modulazione di ampiezza (che ha il notevole vantaggio operativo di consentire l’ascolto a tutti i piloti sintonizzati sulla frequenza localmente utilizzata) a tecniche numeriche per la trasmissione sia dei dati sia della voce. Inoltre una rete di telecomunicazioni fissa collega i vari centri ATC sotto la cui responsabilità l’aeromobile, via via, passa nel proprio percorso.

Telecomunicazioni in senso stretto

Nelle telecomunicazioni in senso stretto si definiscono i metodi e le modalità con i quali delle informazioni sono codificate, trasferite a destinazione, interpretate e gestite.

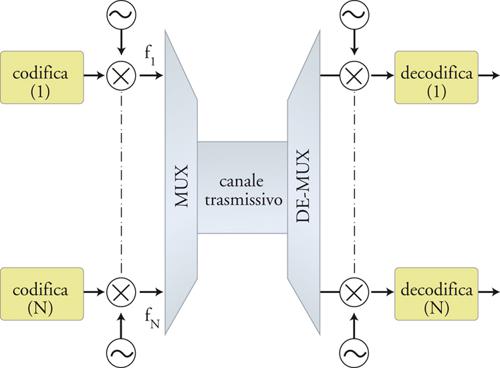

Si distingue tra una funzionalità di trasmissione, nella quale l’informazione, veicolata da un idoneo segnale, è trasferita da un punto a un altro, e una di commutazione, nella quale è instradata verso il destinatario. Le moderne telecomunicazioni sono essenzialmente di tipo numerico; la sorgente informativa, spesso di tipo analogico (voce, video ecc.), viene codificata in forma numerica, generando sequenze di segnali rappresentativi di unità informative o bit. Per consentire l’inoltro sul canale trasmissivo (cavo in rame, fibra ottica, canale radio o etere) i segnali sono modulati, per esempio variandone la frequenza centrale (modulazione di frequenza, chiamata modulazione di lunghezza d’onda nel caso delle fibre ottiche). Questo permette inoltre di trasmettere informazioni provenienti da sorgenti diverse sullo stesso mezzo trasmissivo (fig. 2).

Le prime applicazioni della codifica e modulazione risalgono alle radiocomunicazioni (codice Morse) che incrementarono la sicurezza del trasporto marittimo e, successivamente di quello aereo.

Per consentire l’utilizzo di uno stesso canale trasmissivo a più sorgenti e/o più destinatari occorre ricorrere a tecniche di separazione nei domini che caratterizzano il segnale (banda di frequenza, tempi di utilizzo del canale, codice di trasmissione). Alla multiplazione in divisione di frequenza si affiancano quella a divisione di tempo (in cui ogni sorgente occupa il canale per un assegnato intervallo di tempo) e quella divisione di codice (in cui ogni sorgente si caratterizza per un proprio codice). Nell’accesso di utenti multipli a uno stesso canale trasmissivo si hanno, dunque, il FDMA (Frequency division multiple access), il TDMA (Time division multiple access) e il CDMA (Code division multiple access) o combinazioni di essi. La multiplazione su più livelli permise la telefonia interurbana, internazionale e intercontinentale (quest’ultima con cavi metallici sottomarini e successivamente su fibra ottica).

La rete telefonica (PSTN, Public switched telephone network) è una rete formata da nodi intermedi (detti centrali) e linee trasmissive. Il collegamento tra l’utente e una centrale è una linea formata da due fili di rame, di diametro di ca. 0,6 mm e lunghezza fino a qualche km, chiamata doppino, mentre le linee che collegano le centrali fra loro sono chiamate giunzioni. A una centrale locale fanno capo le linee d’utente, mentre una centrale di transito è collegata solo ad altre centrali. La commutazione durante la fase di formazione della chiamata, consiste nel configurare i contatti all’interno delle centrali in modo da mettere in comunicazione fisica i due utenti. Una volta stabilita la connessione fra i due utenti il circuito dedicato rimane a loro completa disposizione.

La creazione del percorso tra utenti usato nella telefonia analogica tradizionale (POTS, Plain old telephone service) viene detta commutazione di circuito, poiché stabilisce una connessione fisica tra i due utenti per tutta la durata della conversazione. Lo stesso tipo di commutazione, ma con segnali numerici, è usata nella ISDN (Integrated services digital network), introdotta verso la fine degli anni Ottanta e capace di fornire all’utente nella configurazione base due canali B da 64 Kbit/s (attualmente le tecniche DSL, Digital subscriber line, consentono capacità ben maggiori). Con le tecnologie X.25 e Frame Relay le reti evolvono (fine anni Ottanta, inizio anni Novanta) verso la più efficiente commutazione di pacchetto, dove l’informazione da trasmettere viene divisa in gruppi o pacchetti di informazione a cui viene aggiunta un’intestazione (header) che consente di riconoscerli; i pacchetti vengono inviati separatamente, e a destinazione viene ricostruito il messaggio originario riorganizzandoli nel giusto ordine.

Forti cambiamenti relativamente al mondo delle telecomunicazioni sono dovuti all’introduzione delle reti di dati per telecomunicazioni, principalmente alla rete di comunicazione globale Internet. Nell’evoluzione delle telecomunicazioni si distinguono un’era prereti e un’era postreti. Nella prima le telecomunicazioni erano per lo più di tipo analogico e diffusivo (per es., radio e televisione) e le reti erano per lo più basate sulla commutazione di circuito con segnali di tipo analogico. L’introduzione delle reti a pacchetto e poi di Internet ha portato a una nuova visione delle telecomunicazioni, che divengono numeriche e più efficienti. In questo caso è possibile far seguire a pacchetti diversi strade diverse; inoltre è possibile inviare pacchetti provenienti da mittenti diversi sulla stessa linea, rendendo la rete efficiente e flessibile con un risparmio tempo e costi. Anche la comunicazione di tipo diffusivo si trasforma da analogica a digitale con i nuovi canali satellitari digitali, con la televisione digitale terreste, con la diffusione radio in digitale, e infine l’integrazione con la telefonia cellulare.

Nelle moderne telecomunicazioni qualsiasi tipo di informazione (testo, dati, musica, audio, video, immagine) viene digitalizzata e codificata secondo uno standard (codifica di sorgente, come l’MPEG per il video o l’MP3 per l’audio) che permette la rappresentazione sintetica delle informazioni da trasmettere eliminando le ridondanze presenti nel dato di origine e poi trasferita attraverso modalità diverse e mezzi di comunicazione diversi (cavo, onde radio, fibra ottica), indipendentemente dal contenuto; un’ulteriore elaborazione, detta codifica di canale, rende l’informazione adatta a essere trasferita sul mezzo scelto senza degradazioni mediante l’aggiunta di codici di controllo per gli errori. L’evoluzione delle codifiche consente un risparmio notevole sul volume di dati da trasmettere e, allo stesso tempo, rende il dato più robusto relativamente agli errori di trasmissione.

Dal punto di vista dell’utente le possibilità di accesso alle informazioni sono molteplici: (a) TV e radiodiffusione; (b) doppino telefonico, sia per la telefonia tradizionale sia per la comunicazione dati; (c) reti senza fili; (d ) fibra ottica; (e) telefonia mobile.

Grazie alle standardizzazione della rappresentazione dei contenuti (codifica di sorgente) e dei protocolli (metodi con cui i sottosistemi di rete comunicano per scambiare i dati) si va ormai verso una comunicazione seamless, indipendente dal metodo di accesso utilizzato. Si possono citare a tal proposito il Voice over IP in cui le comuni telefonate passano attraverso la rete Internet, la fruizione della TV on demand attraverso la rete internet o la webTV, e servizi del tutto nuovi quali la condivisione dei video (è emblematico il caso di YouTube).

Reti di dati e Internet

Una prima suddivisione delle reti di telecomunicazioni può essere fatta tra reti di accesso e reti di trasporto. Le prime consentono l’accesso dell’utente, le seconde consentono la trasmissione di grandi moli di dati a grandi distanze.

Dal punto di vista geografico e di estensione le reti a loro volta possono suddividersi in reti di tipo locale (LAN, Local area network), reti di tipo metropolitano (MAN) e reti di tipo geografico o esteso (WAN). Infine le reti personali o PAN (Personal area network) si estendono intorno all’utilizzatore per alcuni metri.

Dal punto di vista tecnologico, si distingue tra reticablate (wired ) con connessione in rame o fibra ottica, e reti wireless, con connessioni radio. Nel quadro wireless si delinea la seguente suddivisione: reti PAN che permettono comunicazioni a breve distanza (fino alla decina di metri) su tecnologia standard bluetooth (IEEE 802.15), reti locali (LAN) limitate a piccole aree come edifici, locali pubblici e abitazione domestiche (distanze fino alla centinaia di metri) su tecnologia Wi-Fi (IEEE 802.11) e reti metropolitane basate su tecnologia WiMax (IEEE 802.16) con distanze fino a 50 km.

Una rete senza fili o WLAN (Wireless local area network) è basata su una tecnologia a radiofrequenza (RF) e permette la mobilità all’interno dell’area di copertura, solitamente intorno alle decine di metri dentro gli edifici e alle centinaia di metri all’aperto. Lo standard WiFi (nome commerciale delle reti locali senza fili basate sulle specifiche IEEE 802.11 con le evoluzioni 802.11b, 802.11g) permette di realizzare reti relativamente economiche e di veloce attivazione, operano nella gamma di frequenze (non regolamentata) di 2,4 GHz e consentono di realizzare sistemi flessibili. Accessi WiFi sono ormai disponibili in aeroporti, stazioni ferroviarie, internet cafè; negli ultimi anni, anche alcune province e amministrazioni comunali hanno avviato progetti per la realizzazione di reti civiche con tecnologia WiFi.

WiMax (Worldwide interoperability for microwave access) è il nome commerciale per identificare lo standard IEEE 802.16, ed è una tecnologia senza fili (wireless) che fornisce la connettività su banda larga e ad alta velocità essenzialmente per il cosiddetto ultimo miglio, cioè nel tratto che collega la casa dell’utente alla centrale di telecomunicazioni. Con il WiMax è possibile ottenere un collegamento wireless ad alta velocità, fino a una distanza di 50 km, e a una velocità di 72 Mbps. Le frequenze utilizzate, soggette a licenza d’uso, sono diverse e dipendono dalla versione del protocollo utilizzato, per esempio nella versione mobile (802.16e) coprono le bande di 2,3 GHz, 2,5 GHz, 3,3 GHz, 3,5 GHz e 5,8 GHz. Si prevede che l’evoluzione del WiMax prevista per il 2009 sarà in diretta competizione con le infrastrutture create per la telefonia mobile di terza generazione.

La molteplicità delle reti numeriche diverse per tipologia, estensione, tecnologia e gestione ha trovato uno standard de facto in Internet con il protocollo IP (Internet protocol).

Internet è oggi la più grande rete telematica mondiale, e collega alcune centinaia di milioni di elaboratori. Nata come la rete delle reti, nell’arco di alcuni decenni è divenuta la rete globale. A fine 2007 il numero di utenti Internet – in rapida crescita specie in Oriente – è stimato in un miliardo e seicentomila; la rete trasporta circa il 70% del traffico dati globale. Negli anni Sessanta il progetto ARPANET del Dipartimento della difesa statunitense permise lo sviluppo di una rete telematica fortemente decentralizzata e ridondante, quindi capace di fornire connettività anche se parzialmente distrutta; alla fine della guerra fredda tale tecnologia è stata messa a disposizione per impieghi civili, collegando i principali centri universitari e raggiungendo poi l’utenza aziendale e quella domestica, portando a Internet.

Internet è una rete su scala mondiale che permette la connessione di ogni computer con accesso a una vasta mole di informazioni contenute negli altri computer a essa connessi e messa a disposizione degli utenti in tutto il mondo. Internet funge così da mezzo di raccolta e diffusione delle informazioni su scala mondiale. In realtà raramente un computer è connesso direttamente a Internet; più spesso esso è connesso a una rete (per es., la rete locale aziendale) la quale è a sua volta connessa a Internet (di cui costituisce una sottorete); in altri casi il computer è connesso a Internet via rete telefonica pubblica. Perciò, Internet è spesso definita la rete delle reti.

Internet è una rete logica (cioè prescinde dalla tecnologia utilizzata) assai complessa ed è appoggiata a strutture fisiche e collegamenti di vario tipo; è costituita da reti interconnesse: private, pubbliche, aziendali, universitarie, commerciali, cablate o wireless. Internet ha creato uno standard di comunicazione, consentendo ai più diversi enti e agenti di scambiare dati mediante un protocollo comune, il TCP/IP (Transmission control protocol/Internet protocol), relativamente indipendente da specifiche hardware proprietarie, da sistemi operativi, dai formati dei linguaggi di comunicazione degli apparati e dai mezzi di comunicazione. Forza di questo protocollo è di essere strutturato a strati successivi indipendenti dai precedenti, per cui un pacchetto dati attraversa diversi strati protocollari che aggiungono informazioni.

L’indirizzo di ogni computer viene detto indirizzo IP. Nella versione del protocollo denominata IPv4 questo indirizzo è lungo 32 bit (indicato da quattro numeri compresi tra 0 e 255 separati da punti) e permette l’indirizzamento di circa quattro miliardi di computer. La crescita della dimensione di Internet ha reso però insufficiente questo numero ed è stata così definita una nuova versione del protocollo (IPv6) che aumenta la lunghezza dell’indirizzo a 128 bit (e il conseguente numero di computer a circa 3×1038). La transizione da IPv4 ad IPv6 è graduale (mantenendo la compatibilità nei due sensi) e durerà alcuni anni.

Ottenuta la connessione a Internet, l’utente è in grado, attraverso l’utilizzo di opportuni software installati sul proprio computer di svolgere attività quali: (a) la consultazione di banche dati e di cataloghi; (b) la visione di documenti, anche in forma grafica, emessi da altri utenti (incluse le versioni on line di quotidiani/periodici); (c) il trasferimento diretto di propri file nella memoria di massa dei computer di altri utenti; (d) l’invio e la ricezione di messaggi di posta elettronica o istantanei; (e) la ricezione di musica, filmati, programmi di emittenti radiotelevisive; (f) la gestione diretta delle operazioni di finanza personale (home banking e trading on line); (g) l’acquisto di beni di consumo o servizi.

Tra i principali servizi e le applicazioni disponibili su Internet vi sono: World Wide Web, motori di ricerca, FTP (File transfer protocol), e-mail, mailing list, newsgroup, webcast, file sharing, chat, podcast, IPTV (Internet protocol television), forum, VOIP, steaming, web radio, blog, e-commerce, e-learning, multiplayer.

Attualmente ai servizi tradizionali si affiancano i servizi denominati Web 2.0, che pongono al centro i contenuti e l’interazione tra gli utenti; le capacità di condivisione dei dati trasformano i consumatori passivi in autori di contenuti messi a disposizione della comunità; esempi di questa filosofia sono i blog, i social network, e il podcasting.

L’utenza domestica può accedere a Internet mediante gli Internet service provider (ISP) che portano la rete fino a casa dell’utente sfruttando la tecnologia disponibile. Il collegamento finale tra la rete di telecomunicazioni e l’utente domestico, il cosiddetto ultimo miglio, costituisce ancora la parte preponderante degli investimenti nelle infrastrutture di telecomunicazioni. Le più diffuse tecniche di accesso che utilizzano lacoppia di conduttori in rame (il tradizionale doppino telefonico) sono la tecnica ADSL (Asymmetric digital subscriber line) e quella VDSL (Very high rate digital subscriber line).

L’ADSL deve il suo nome all’asimmetria delle velocità massime raggiungibili nei due versi (utente-rete e rete-utente). Per i servizi di telecomunicazioni in genere la quantità di informazioni che l’utente preleva dalla rete è assai maggiore di quella che egli stesso invia. Su distanze brevi (inferiori a 2,5 km) l’ADSL permette una velocità di cifra massima di 9 Mbit/s nella direzione dalla rete verso l’utente (downstream) e di 1 Mbit/s nella direzione opposta (upstream). L’ADSL2 estende la capacità dell’ADSL nella velocità di trasmissione che può, nelle condizioni migliori, raggiungere una velocità di downstream di 12 Mbit/s e di 3,5 Mbit/s in upstream dipendente dalla qualità della linea. Infine l’ADSL2+ può arrivare fino a 24 Mbit/s in downstream e 1,5 Mbit/s in upstream.

A partire dall’ultima centrale di commutazione telefonica, la distribuzione del segnale verso l’utente avviene tipicamente mediante un primo spezzone di fibra ottica, e un tratto finale in rame.

Il punto di demarcazione tra la tratta in fibra ottica e quella in rame può essere posizionato più o meno vicino all’utente finale. Si distingue tra FTTH (Fiber to the home) se il collegamento verso l’utente è realizzato interamente in fibra ottica, FFTB (Fiber to the building) se la fibra ottica arriva fino allo scantinato dell’abitazione dell’utente, FTTC (Fiber to the curb) se l’armadio di distribuzione da cui parte la tratta in rame è posizionato immediatamente all’esterno dell’edificio dove si trova l’utente.

A queste modalità con fibra ottica, cavo, filo (wired) si vanno ad affiancare le modalità wireless (WiMax) e le modalità legate alla telefonia cellulare (sistemi GPRS, EDGE, UMTS, descritti nel seguito); esiste infine la possibilità di sfruttare la rete elettrica (servizi PLC, Powerline communication).

Diffusione TV e radio

La TV, come le reti, ha seguito una sua linea evolutiva e alla diffusione (broadcasting) effettuata con una rete dedicata di ripetitori televisivi sparsi sul territorio si sono affiancati altri metodi diffusivi.

In base al metodo di trasmissione utilizzato nel tratto di rete che giunge all’utente, si distingue la televisione terrestre, se utilizza radiotrasmettitori posti sulla superficie della Terra, la televisione satellitare, se utilizza onde radio emesse da trasmettitori a bordo di satelliti artificiali, la televisione via cavo, se utilizza cavi per telecomunicazioni. Gli standard di codifica delle immagini video variano nel tempo: quelli dell’attuale diffusione televisiva di massa risalgono all’introduzione del colore negli anni Sessanta e prevedono la trasmissione nelle gamme VHF e UHF con i noti sistemi PAL, SECAM e NTSC; in Europa è stato inoltre sviluppato, negli anni Ottanta, per la diffusione diretta da satellite, lo standard MAC (Multiplexed analogue components).

I servizi di videoinformazione si adeguano alla tendenza d’uso delle reti numeriche, che permettono maggiore qualità, flessibilità nella combinazione di diversi servizi, facilità di cifratura per proteggere le informazioni e controllo dell’accesso.

Nel settembre del 1993 nasce in Europa il Digital video broadcasting (DVB) attraverso la firma di un Memorandum of understanding da parte di 80 operatori del settore volto a produrre specifiche tecniche su cui definire gli standard per la diffusione televisiva digitale. Il DVB ha prodotto standard per ciascun mezzo trasmissivo (terrestre, satellite, via cavo) utilizzato dalla TV. In particolare: (a) il DVB-S (S, satellite), per ricevere i segnali video con un ricevitore satellitare collegato a un’antenna generalmente di tipo parabolico; (b) il DVB-C (C, cable), per la TV via cavo; (c) il DVB-T (T, terrestrial), per il digitale terrestre (in cui il segnale televisivo è ricevuto attraverso le normali antenne televisive); (d) il DVB-H (H, Handheld), che costituisce lo standard per la radiodiffusione verso terminali mobili quali i telefoni cellulari.

Infine, il più recente e ancora in fase di test DVB-SH (Digital video broadcasting-satellite services to Handhelds) è un’evoluzione del DVB-H che permette l’integrazione con reti ibride satellitari/terrestri. All’inizio del 2008 la Corea del Sud e il Giappone contano 20 milioni di telespettatori mobili, più di 30 volte il numero di utenti nell’Unione Europea.

La televisione ad alta definizione (HDTV, High definition television) ha introdotto immagini video di qualità significativamente superiore a quello degli standard televisivi analogici. A differenza della TV tradizionale, in cui si ha il formato standard 4:3 e quello widescreen 16:9 per le immagini sullo schermo televisivo, l’alta definizione ha come standard il 16:9. Un quadro video tradizionale nel sistema PAL è composto da 625 linee (trasmesse in modo interallacciato, 25 o 30 volte al secondo le linee pari, 25 o 30 volte al secondo le linee dispari). La risoluzione orizzontale del quadro nel video tradizionale analogico è funzione della larghezza di banda del segnale (un segnale di qualità adatto alla trasmissione ha una banda di 5 MHz, sufficienti per risolvere circa 400 linee). Nella TV digitale lo standard di campionamento prevede 720 pixel sull’asse orizzontale, qualità massima ottenibile da una trasmissione DVB o da un DVD. La tecnologia HDTV comprende quattro formati video, che differiscono sia per la risoluzione effettiva sia per le modalità di scansione dell’immagine. I due più noti sono: (a) il formato 720p, comunemente chiamato HD READY, che presenta una risoluzione di 921.600 pixel (1280×720) con scansione progressiva, per cui per ciascun ciclo di trasmissione (50 o 60 Hz a seconda dei Paesi) viene trasmesso l’intero quadro dell’immagine; (b) il formato 1080p, comunemente chiamato FULL HD, che presenta una risoluzione di 2.073.600 pixel (1920×1080), anch’esso a scansione progressiva.

Nel progressivo passaggio dall’analogico al digitale anche le trasmissioni in radiodiffusione passano dalla vecchia trasmissione in modulazione di ampiezza (AM) e, nella gamma VHF (88÷108 MHz), in modulazione di frequenza (FM) alla radiodiffusione digitale. Esempio notevole di questo passaggio è il DAB (Digital audio broadcasting), sviluppato in Europa nell’ambito del progetto EUREKA 147 e attualmente introdotto in numerosi paesi anche al di fuori dell’Europa (un’eccezione importante sono gli Stati Uniti, che hanno sviluppato un proprio protocollo denominato IBOC, In band on channel). La trasmissione in codifica digitale del DAB presenta gli stessi vantaggi della radiodiffusione televisiva e può, in principio, operare su frequenze tra 30 MHz e 3 GHz per la ricezione mobile o frequenze maggiori nel caso di una ricezione fissa; le trasmissioni DAB sono oggi effettuate nella banda 174÷240 MHz o nella banda L (1452÷1492 MHz).

Infine si parla di IPTV (Internet protocol television) per indicare un sistema dove il servizio televisivo è trasmesso utilizzando il protocollo Internet: i contenuti televisivi sono ricevuti dall’utente attraverso le reti di dati. Secondo alcuni esperti di media, entro pochi anni la diffusione tradizionale TV sarà soppiantata da queste nuove tecnologie. Per l’utenza domestica la IPTV è spesso offerta insieme ai servizi Internet a banda larga e al VoIP (Voice over internet protocol). L’offerta commerciale combinata di IPTV, VoIP e accesso a Internet viene chiamata Triple play (se si aggiunge la mobilità si parla di Quadruple play).

Telefonia mobile

Le telecomunicazioni mediante terminali mobili (i telefoni cellulari) ha avuto negli anni Novanta un notevole impulso: si fa distinzione tra sistemi cordless, in cui la mobilità è limitata all’ambito domestico o al più urbano, chiamati anche sistemi a bassa mobilità, e sistemi cellulari su larga scala, che consentono all’utente gli spostamenti sull’intero territorio nazionale o anche all’estero. In entrambi i casi il territorio coperto è suddiviso in aree di servizio elementari dette celle. Nel caso più semplice del sistema cordless domestico la cella è costituita dall’abitazione dell’utente e non è possibile spostarsi al di fuori di essa. Negli altri casi è invece possibile la mobilità da una cella a un’altra cella adiacente e il trasferimento della chiamata tra le due celle viene denominato handover. Se è possibile continuare a usufruire del servizio anche quando ci si sposta all’interno di reti gestite da operatori diversi da quello con cui si è sottoscritto l’abbonamento, si parla di roaming.

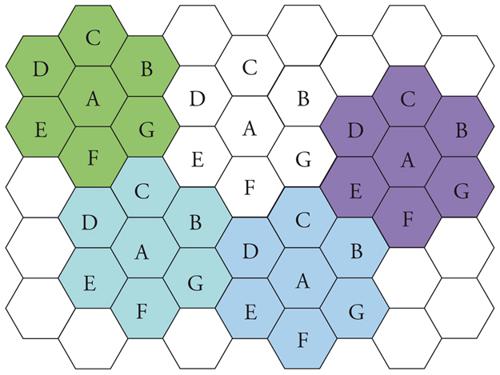

La suddivisione in celle è necessaria per poter servire zone estese e permettere a molti utenti di accedere contemporaneamente al servizio pur avendo un numero limitato di canali radio a disposizione. Si riutilizzano allora, in celle debitamente distanti tra loro gli stessi canali; occorre quindi adottare uno schema opportuno di riuso dei canali nello spazio.

Facendo riferimento a una griglia regolare di celle esagonali e supponendo i terminali uniformante distribuiti nell’area di servizio, è possibile assegnare lo stesso numero di canali radio a ogni cella. Le celle vengono allora raggruppate in grappoli (cluster) di dimensione N (fig. 3) e all’interno di ogni cluster si fa uso di tutti i canali radio del sistema.

In generale si distingue tra sistemi mobili di prima generazione, analogici e con accesso a divisione di frequenza (FDMA), come il TACS (Total access communication system), di seconda generazione, numerici, con accesso a divisione di tempo (TDMA) come il GSM (Global system for mobile comunication), di terza generazione, numerici, con accesso a divisione di codice (CDMA) a banda larga (W-CDMA) come l’UMTS (Universal mobile telecommunications system), che consentono un alto flusso binario (fino a 2 Mbit/s), la capacità di trasporto di ‘pacchetti’, il supporto di servizi multimediali, la variabilità dei parametri della Qualità del servizio (QoS).

Il lancio dei nuovi sistemi di telefonia mobile GSM e l’UMTS ha reso obsoleto il TACS che, dopo aver consentito la rapida diffusione iniziale della telefonia mobile in Italia, ha smesso di funzionare a fine 2005 cedendo le sue frequenze al GSM. La standardizzazione del sistema GSM è cominciata nel 1982 e il suo lancio in Europa è avvenuto dieci anni dopo. Nei sistemi mobili il collegamento tra la rete fissa e l’utente è garantito nel GSM da una stazione radio base chiamata BTS (Base transceiver station), operante in Europa nella gamma dei 900 MHz (876÷960 MHz) e dei 1800 MHz (1710÷1880 MHz). L’intero territorio è diviso in areole, ognuna delle quali è coperta da una di queste stazioni. Oltre al servizio telefonico, la rete GSM può essere impiegata per l’invio di dati e fax. In particolare è disponibile un servizio Short message service (SMS) che permette lo scambio di messaggi alfanumerici con lunghezza massima di 160 caratteri, che ha avuto un diffusione inattesa e una forte esplosione nel mercato delle telecomunicazioni

A questi servizi si affiancano i servizi GPRS (General packet radio service), progettati per realizzare il trasferimento di dati a media velocità, usando i canali TDMA della rete GSM. Un’ulteriore evoluzione è la tecnolo-gia EDGE (Enhanced data rates for GSM evolution),che consente di raggiungere velocità maggiori, fra 20 e 200 kbit/s, a seconda del modello di cellulare/terminale usato (classe del cellulare), del numero di utenti collegati per cella e infine della distanza fra il terminale e l’antenna più vicina.

Il più recente sistema UMTS, infine, oltre al classico trasporto del segnale vocale, supporta un transfer rate massimo di 1920 kbit/s. Le applicazioni tipiche, per esempio nelle reti UMTS in Italia, sono: voce, videoconferenza e trasmissione dati a pacchetto. Dal 2004 sono presenti anche in Italia l’UMTS 2 e l’UMTS 2+, due estensioni del protocollo UMTS, che funzionano sulle attuali reti UMTS e raggiungono velocità rispettivamente di 1,8 e 3 Mbit/s.

In un prossimo futuro le attuali reti UMTS saranno potenziate attraverso la tecnologia di accesso denominata HSDPA (High speed downlink packet access), con una velocità massima teorica verso l’utente di 10 Mbit/s.

Le bande di frequenza originariamente previste per lo standard UMTS sono 1885÷2025 MHz e 2110÷2200 MHz, rispettivamente per la trasmissione e la ricezione.

Evoluzione delle telecomunicazioni

L’evoluzione delle telecomunicazioni negli ultimi decenni è caratterizzata dall’integrazione della trasmissione e dell’elaborazione delle informazioni, da cui l’acronimo ICT (Information and communication technologies); tale integrazione è spinta dal continuo aumento, a parità di costi, delle capacità di calcolo, di memorizzazione e di trasmissione, valutabile di massima in un raddoppio in meno di due anni. Per esempio: (a) la legge empirica di Moore indica in 18 mesi il tempo di raddoppio delle capacità dei microprocessori; (b) le memorie portatili compact flash, inizialmente dell’ordine di 32÷64 milioni di byte, sono arrivate in pochi anni a decine di gigabyte, cioè di miliardi di informazioni elementari, mentre i dischi rigidi si avvicinano alla capacità del terabyte (1000 gigabyte) e nel mondo esistono centinaia di banche dati con capacità superiore al petabyte (un milione di gigabyte); (c) infine, la capacità trasmissiva sulla rete di trasporto in fibra ottica, grazie alle tecnologie fotoniche (DWDM, Dense wavelength division multiplexing), permettono il trasporto di alcuni terabit al secondo su singola fibra. Nell’intero pianeta sono registrati (novembre 2007) dati per 161 exabyte (cioè 161 miliardi di gigabyte) e il traffico di posta elettronica nel solo 2006 ha generato (esclusi i messaggi SPAM) 6 exabyte.

Nel quadro europeo, la metà della crescita della produttività negli ultimi venti anni è dovuta all’utilizzo delle ICT in tutti i settori della società nonché al loro sviluppo nelle stesse imprese. Le tendenze evolutive sono molteplici, e risiedono in un contesto di passaggio, nei Paesi maggiormente industrializzati, da un’economia prevalentemente di prodotti a una prevalentemente di servizi, nella quale il valore aggiunto risiede nell’informazione fornita all’utente piuttosto che nel suo supporto fisico (per es., alla tradizionale distribuzione e vendita di libri si sta affiancando la loro stampa on demand con abbattimento dei costi di distribuzione e magazzino, processo simile alla assai più diffusa distribuzione di musica via Internet, che sta sostituendo il precedente, ricco mercato dei CD musicali). In tale contesto, gli apparati e i sottoassiemi ICT, specie quelli di utente, sempre più di produzione orientale (Giappone, Cina, Corea, Taiwan e, soprattutto per la componente software, India), di costi contenuti e di caratteristiche standardizzate, vengono spesso prodotti per ditte che sono concorrenti sul mercato globale, e la competizione, specie nelle nazioni a maggior reddito procapite, si sposta sulla fornitura dei servizi e sulla produzione dei contenuti multimediali come i filmati o video; gli apparati possono apparire gratuiti all’utente, (come nel caso dei set-top box necessari per fruire della pay-TV), o spesso forniti in comodato gratuito o a prezzo simbolico con la clausola di una spesa minima mensile. In tale quadro l’infrastruttura di telecomunicazioni che sfrutta diverse tecnologie (per es., Wi-Fi, UMTS ecc.) è comunque essenziale per l’erogazione del servizio e/o la gestione e l’aggiornamento del prodotto nella sua componente software.

La spinta della tecnologia (technology push) e le esigenze di mercato (market pull ), dunque, modificano profondamente il panorama dei servizi di telecomunicazioni con tre principali linee evolutive. La prima evoluzione è verso l’accesso alle informazioni ovunque e senza soluzione di continuità (seamless, ubiquitous access) in modo trasparente rispetto alle tecnologie utilizzate, anche tramite SDR (Software defined radio). La seconda, a essa collegata, è verso la fornitura di informazioni – o l’accesso a informazioni – che hanno senso nel particolare luogo e momento in cui si trova l’utente, il che comporta la sua localizzazione e la costruzione di un suo profilo (con ovvii problemi di riservatezza). La terza risiede nella crescente necessità di rendere coerenti (sincronizzare, allineare) informazioni residenti in diversi supporti fisici gestiti da un utente o di condividerle tra più utenti, secondo un modello noto come peer to peer, che permette la trasmissione in tempo reale di contenuti video tra utenti dotati di connessioni a elevata capacità trasmissiva, sia in ricezione sia in trasmissione (i tipi di file maggiormente condivisi sono gli Mp3, i file musicali e i DivX contenenti i film).

Infine, ai servizi d’utente si affiancano nuove applicazioni di telecomunicazioni nel quadro della comunicazione da/tra oggetti. Tra di esse emergono le wireless sensors networks, costituite da un gran numero (anche centinaia di migliaia) di minuscoli elementi a basso costo e a bassissimo consumo energetico con capacità sensoriale e trasmissiva, che permettono di acquisire in modo automatico parametri e dati ambientali di varia natura, di sintetizzare e assimilare le informazioni mediante elaborazione locale e di renderle disponibili a un centro di controllo. Nel quadro delle comunicazioni tra oggetti evolvono le NFC (Near field communications) che rientrano nel progetto europeo SmartTouch, basato su cosiddetti oggetti intelligenti che vengono toccati con un lettore mobile, integrato per esempio in un telefono cellulare, con cui l’utente può ottenere informazioni o effettuare un pagamento. La comunicazione SmartTouch si basa sulla tecnologia di identificazione a radiofrequenza (RFID, Radio frequency identification) nonché sull’interfaccia e sul protocollo di connessione senza fili a breve raggio NFC, simile allo standard bluetooth, ma con raggio d’azione limitato ad alcuni centimetri.

Alle telecomunicazioni in senso stretto si affiancano, tanto sotto l’aspetto teorico e tecnico, quanto nelle applicazioni e nei sistemi integrati, il rilevamento (sorveglianza e telerilevamento) e la radionavigazione.

Il rilevamento definisce i metodi e le modalità con i quali è possibile acquisire informazione su oggetti o sull’ambiente circostante, che in questo caso sono le sorgenti di informazioni da rendere disponibili all’utente attraverso opportuni trattamenti del segnale e dei dati.

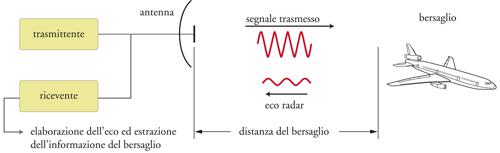

I sistemi di rilevamento possono essere classificati in due tipi: attivi e passivi. Nei sistemi attivi, quali i radar e i sonar attivi, gli oggetti e/o l’ambiente circostante vengono stimolati mediante opportuni segnali. I segnali riemessi in risposta a tali sollecitazioni vengono ricevuti ed elaborati dal sistema di rilevamento stesso. Nei sistemi passivi, quali i radiometri (operanti a microonde, nell’infrarosso e nel visibile), i sonar passivi e i sensori di immagine ottici (per es., foto e videocamere), si utilizza l’emissione degli oggetti di interesse, dovuta a illuminazione esterna (Sole) o spontanea (a microonde e nell’infrarosso termico).

Quando si impiega un sistema di rilevamento per lo studio a distanza dell’ambiente naturale, e in particolare per la misura di parametri senza contatto diretto, si parla di telerilevamento. Le informazioni provenienti dal telerilevamento trovano impiego nelle scienze della Terra, nell’analisi delle risorse, nella gestione del territorio e nella protezione civile per scopi di sicurezza.

In relazione alle varie esigenze, un sistema di rilevamento può essere fisicamente collocato su diversi supporti (o piattaforme) fissi o mobili, di tipo terrestre, aereo, navale o satellitare. Si parla di sorveglianza quando si prevede la rivelazione (detection) e la localizzazione di oggetti quali aerei e navi per scopi di sicurezza.

Nell’ambito del rilevamento e di gestione del traffico (sia per analisi dell’ambiente sia per sorveglianza) il sensore più significativo è il radar, in grado di misurare almeno la distanza (ranging) di oggetti presenti nell’ambiente circostante attraverso l’emissione di onde radio. Le applicazioni del radar sono molteplici (radar di sorveglianza, radar di inseguimento, radar ad altissima risoluzione per formazione di immagini, radar altimetri, radar meteorologici). Il principio di funzionamento del radar monostatico a impulsi (quello più diffuso) è molto semplice: a intervalli regolari un trasmettitore di potenza emette un segnale, di norma di durata molto inferiore al periodo di ripetizione del segnale stesso, che viene irradiato con una antenna fortemente direttiva (fig. 4). La stessa antenna viene utilizzata per ricevere l’eco riflessa dall’oggetto di interesse, tradizionalmente chiamato bersaglio, attraverso un ricevitore molto sensibile. Il tempo impiegato dall’impulso per colpire l’oggetto e tornare indietro è pari al doppio della distanza tra il radar e il bersaglio diviso la velocità di propagazione delle onde radio (velocità della luce). I dati combinati dell’orientamento dell’antenna all’atto dell’emissione dell’impulso e del tempo di ricezione dell’eco del segnale forniscono la posizione del bersaglio nel campo di copertura del radar. L’intensità dell’eco diminuisce molto rapidamente al crescere della distanza (in spazio libero, la potenza dell’eco varia in ragione inversa della quarta potenza della distanza); pertanto per rilevare e localizzare bersagli molto distanti (centinaia di km) dal radar occorre trasmettere potenze molto elevate (dell’ordine delle centinaia di kW o del MW come valori di picco). Viceversa, nel caso di bersagli relativamente vicini (decine di metri, come nei radar per autoveicoli) le potenze di picco necessarie possono essere limitate ai mW.

Oltre a misure di distanza e angoli (attraverso il puntamento dell’antenna) i radar possono effettuare anche misure di velocità attraverso l’effetto Doppler.

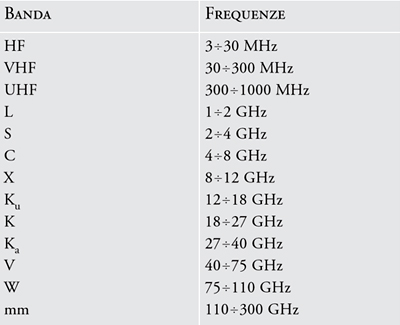

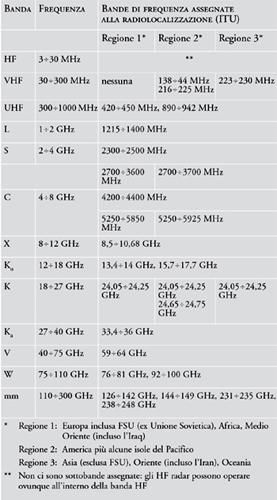

Le bande di frequenza utilizzabili dai radar sono denominate ancora oggi con delle lettere che risalgonoalla seconda guerra mondiale: L, S, C, X, K; questesono state recepite come standard per la designazione delle bande radar. Gli intervalli di frequenza corrispondenti a queste denominazioni sono riportate in tab.1.L’assegnazione delle bande di frequenza utilizzabili dal radar, così come la gestione dell’intero spettro elettromagnetico, è compito della International Telecommunications Union (ITU/UIT) attraverso una serie di conferenze periodiche, chiamate WARC (World Administrative Radio Conference). L’elenco completo delle frequenze alla radiolocalizzazione (radar) è riportato in tab. 2. È da notare che i radar militari possono non rispondere alle norme ITU.

Sorveglianza

La sorveglianza comporta varie fasi alcune delle quali sono indicate di seguito: (a) scoperta, ossia rivelazione e prima localizzazione dell’oggetto; (b) inseguimento, che consiste nell’estrapolazione della posizione dell’oggetto in istanti successivi in modo da realizzare un tracciamento (tracking) con stima della posizione e della velocità; (c) identificazione dell’oggetto.

Un’idonea funzione di sorveglianza è richiesta nel controllo del traffico aereo o marittimo e nella difesa aerea territoriale. L’applicazione principale per la sorveglianza è quella svolta dai radar militari per la scoperta aerea e dai radar civili nel controllo del traffico aereo (ATC, Air traffic control). I sistemi radar utilizzati per la sorveglianza sono stati classificati in radar primari (PSR, Primary surveillance radar) e radar secondari (SSR, Secondary surveillance radar).

Per effettuare il controllo in rotta di un aeromobile un radar primario ha, tipicamente, una portata fino a circa 360 km, fornisce dati aggiornati ogni 8÷12 s e ha una capacità di discriminazione angolare migliore di 1,5° e di discriminazione in distanza di 600 m. Per soddisfare questi requisiti un radar primario ha una grande antenna fortemente direttiva in azimut e poco direttiva in elevazione (per permettere di rilevare aerei ad altitudini diverse) e un trasmettitore di potenza elevata (dell’ordine del MW come potenza di picco).

I radar secondari risalgono agli anni Sessanta come applicazioni ATC di un sistema militare di identificazione amico-nemico (IFF, Identification friend or foe) messo a punto durante la Seconda guerra mondiale. In un sistema SSR la stazione di terra (comunemente chiamata il radar) invia all’aeromobile segnali standard alla frequenza centrale di 1030 MHz, denominati interrogations (interrogazioni SSR) con opportuna codifica. Questi segnali vengono decodificati dal trasponditore a bordo il quale risponde di conseguenza inviando a terra dei segnali standard alla frequenza centrale di 1090 MHz, chiamati replies (risposte, repliche). La misura della distanza e dell’azimut dell’aeromobile si basano sugli stessi metodi del radar primario; il sistema SSR aggiunge, un canale di comunicazione con il velivolo, che include la trasmissione a terra dell’identificativo e della quota del velivolo (rispettivamente, interrogazioni e risposte di modo A e C). Un’evoluzione del SSR, denominata Modo S (dove S sta per selettivo), riduce le interferenze e aumenta la capacità di indirizzamento e di scambio dati; il Modo S è ormai il sistema standard che sostituisce l’SSR tradizionale.

Si stanno affiancando ai radar tradizionali i nuovi sistemi distribuiti di localizzazione e sorveglianza dei velivoli cooperanti, che spesso consentono prestazioni migliori a costi più contenuti. Un notevole sistema distribuito di sorveglianza è la multilaterazione (MLAT), che utilizza la ricezione, da parte di un certo numero di stazioni a terra, dei segnali emessi da transponder SSR installati a bordo degli aeromobili per la localizzazione di velivoli sulla superficie dell’aeroporto, e da uno o più transponder di riferimento in posizioni note. Gli aeromobili, e i veicoli aeroportuali di servizio equipaggiati, sono localizzati tramite le differenze dei tempi di arrivo del segnale SSR da essi emesso a più (almeno quattro) stazioni riceventi. I sistemi MLAT consentono accuratezze migliori di 7,5 m su tutto l’aeroporto e possono essere estesi alle aree adiacenti (TMA, Terminal manoeuvering area), nel qual caso si parla di Wide Area MLAT o WAM per la sorveglianza degli aeromobili in avvicinamento o in transito entro circa 50÷100 km dall’aeroporto.

Un’ulteriore evoluzione del concetto di sorveglianza distribuita viene realizzato integrando le funzioni di navigazione. L’ADS-B (Automatic dependent surveillance-broadcast) è un caso notevole nel quale aeromobili (e veicoli di terra cooperanti) trasmettono periodicamente via data link e in maniera broadcast le stime del proprio vettore di stato (posizione velocità ecc.) in un canale di comunicazione dedicato (Modo S, Data Link in VHF o UAT, Universal acces trasponder). Il vettore di stato è derivato dal sistema di navigazione di bordo dell’aeromobile. La trasmissione è automatica e avviene periodicamente; tutti i sistemi opportunamente equipaggiati e sotto copertura radio possono ricevere i report ADS-B. Gli utilizzatori di tali dati sono principalmente gli operatori ATC, e inoltre gli aeromobili e i veicoli che filtrando i dati di loro interesse possono avere un immagine del traffico che li circonda.

Telerilevamento

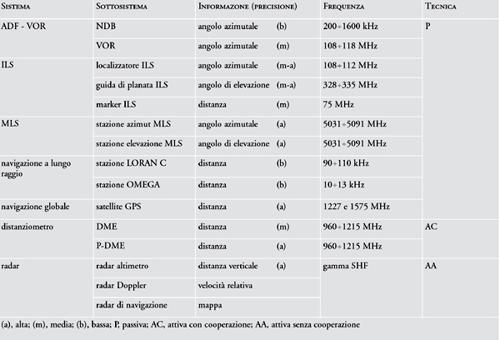

I sensori per telerilevamento possono sfruttare le capacità di emissione degli oggetti di interesse e l’illuminazione naturale (sensori passivi) oppure (sensori attivi) utilizzare le capacità di retrodiffusione (backscattering) della radiazione prodotta dal sensore stesso. I sensori attivi per telerilevamento a microonde sono essenzialmente radar; rispetto ai sensori passivi, a fronte di maggiore complessità e costo, presentano il vantaggio, fondamentale nelle regioni con copertura nuvolosa, di non subire apprezzabilmente gli effetti di mascheramento determinato dagli strati nuvolosi e di poter operare di giorno o di notte. Nelle applicazioni di telerilevamento occorre ottenere risoluzioni spaziali (e quindi angolari) molto elevate, non raggiungibile con tecniche radar tradizionali. È questo il caso del rilevamento (e della creazione di mappe) della superficie terrestre da radar montati a bordo di aerei (piattaforme avioniche) o di satelliti (piattaforme spaziali), le applicazioni più diffuse di telerilevamento. In questi casi viene utilizzata la tecnica SAR (Synthetic aperture radar), con cui, grazie alla sintesi dell’apertura tramite elaborazione coerente del segnale, è possibile ottenere un’elevata risoluzione spaziale, indipendente dalla lunghezza d’ onda e dalla quota. I principali sensori per telerilevamento (attivi e passivi) sono elencati in tab. 3.

La tecnica SAR, le cui applicazioni avioniche con tecnologie analogiche risalgono agli anni Cinquanta, utilizza il moto della piattaforma per realizzare, tramite elaborazione del segnale, un’antenna virtuale molto lunga (ordine di grandezza del km nelle applicazioni spaziali) che consente di ottenere un’elevatissima risoluzione nella direzione del moto (risoluzione di azimut o cross-range); un’opportuna forma d’onda trasmessa permette di ottenere una risoluzione dello stesso ordine nella direzione perpendicolare (direzione di range); viene così ottenuta dallo spazio l’immagine di una strisciata (swath) la cui larghezza tipica va dalle decine al centinaio di km, elevabile a qualche centinaia (degradando la risoluzione) mediante tecniche particolari, una delle quali è la SCANSAR (SCANning SAR, SAR a scansione nella direzione di range). La risoluzione di un SAR spaziale è tipicamente dell’ordine della decina di metri nelle applicazioni civili e può scendere sotto il metro nel modo spotlight; di principio essa non dipende dalla distanza né dalla lunghezza d’onda di funzionamento. L’indipendenza dall’illuminazione e dall’emissione naturale rende il SAR indispensabile per il telerilevamento con ogni situazione meteorologica, in ogni ora della giornata e, nel caso dell’uso di lunghezze d’onda decimetriche (banda L, intorno a 22÷24 cm; banda P, intorno a 62÷64 cm) consente la penetrazione del fogliame e anche del terreno arido, per esempio desertico, con rivelazione di manufatti sepolti (archeologia).

Dagli anni Novanta c’è una crescente disponibilità per usi civili di tecnologie e prodotti precedentemente sviluppati per scopi militari (immagini a elevatissima risoluzione). Un’applicazione notevole della tecnologia SAR recente si ha nel sistema COSMO-SkyMed, finanziato dall’ASI (Agenzia Spaziale Italiana) e dal Ministero della Difesa italiano, composto da una costellazione di 4 satelliti; i primi due sono stati lanciati l’8 giugno 2007 e il 9 dicembre 2007. Ognuno dei quattro satelliti è equipaggiato con un SAR multimodale in banda X. Il sistema, di uso duale (civile e militare), permetterà il monitoraggio costante del territorio attraverso il controllo continuo di coste, risorse agricole e forestali, ambiente urbano. In ambito estero, sviluppi notevoli, sebbene non altrettanto sofisticati, sono: (a) il sistema SAR-Lupe (con una costellazione di 5 satelliti di peso 720 kg e potenza 250 W), destinato a fornire immagini SAR (sensore in banda X) ad alta risoluzione (migliore di un metro) al ministero delle difesa tedesco, con i primi tre satelliti lanciati a dicembre 2006, luglio 2007 e novembre 2007; (b) il satellite radar TerraSAR-X, lanciato con successo il 15 giugno 2007 dalla base russa Cosmodrome in Kazakhistan, come partnership pubblico-privata tra l’ente aerospaziale germanico DLR e la società EADS Astrium GmbH con lo scopo (con un satellite simile che opererà in formazione col primo, realizzando la missione TanDEM-Xi il cui lancio è previsto per la primavera 2009) di costruire un modello digitale di elevazione (DEM) globale e ad alta precisione; la tecnica utilizzata, in questo caso, è l’interferometria SAR.

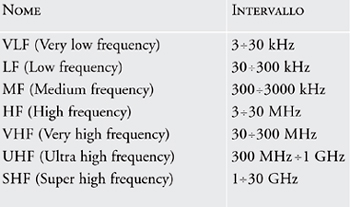

Per radionavigazione si intende il processo mediante cui, attraverso l’uso di onde radio, un mobile è in grado di navigare, cioè raggiungere la destinazione con un percorso ben definito attraverso la determinazione della propria posizione e la guida. I sistemi di radionavigazione (si farà riferimento principalmente a quelli aeronautici per uso civile) operativi o in fase di sperimentazione hanno architetture, funzioni e prestazioni differenti in dipendenza dalla dimensionalità (2D, cioè latitudine e longitudine, oppure 3D, con l’aggiunta della quota) della determinazione, dalle condizioni della navigazione (velocità del mobile, visibilità e distanza dagli ostacoli) e dall’ordine di grandezza della distanza massima entro cui i sistemi devono operare, strettamente correlata alla scelta della gamma di frequenza delle radioonde impiegate (tab. 4). Con radioaiuti posti sulla superficie della Terra si possono coprire distanze dell’ordine di 1000 km, a condizione di servirsi della propagazione per onda di terra, condizionata dall’uso di basse frequenze (nelle gamme VLF e LF). Altrimenti, impiegando la propagazione per onda diretta in visibilità (nelle gamme VHF, UHF, SHF), si limitano le distanze – con radioaiuti terrestri – entro 50 km o 400 km circa, rispettivamente per navi o aeromobili; tale limitazione non sussiste quando i radioaiuti sono posti su satelliti artificiali. Si distinguono dunque tre classi di sistemi di radionavigazione: (a) i sistemi a lungo raggio, di bassa precisione (tipicamente, decine di km o km), per la navigazione sugli oceani; (b) i sistemi a breve raggio, di media precisione (tipicamente, km o centinaia di metri), per la navigazione marittima costiera e quella aerea su terra; (c) i sistemi per atterraggio, di precisione alta (da centinaia a decine di metri) e altissima (da decine di metri a metri o anche sotto il metro nel caso di atterraggio in assenza di visibilità). Con la disponibilità dei satelliti artificiali è stato possibile l’avvento di una quarta classe, quella dei sistemi satellitari, capaci di operare con media o alta precisione (e, con l’ausilio di opportuni sistemi terrestri, di altissima precisione) su tutta la superficie terrestre e in tutto lo spazio che circonda la Terra. Sono ben noti i sistemi GPS (statunitense), GLONASS (russo) e il nuovo sistema europeo Galileo in fase di sviluppo.

Esempi di sistemi a lungo raggio sono il LORAN C e l’OMEGA. Nel LORAN C (Long range navigation C) si ricevono i segnali da almeno tre stazioni emittenti, una principale e le altre asservite. Il metodo utilizzato per la determinazione della posizione è quello iperbolico, ovvero si misura la differenza delle distanze da due coppie di punti noti; l’errore di posizione varia da 300 m a 15 km, a seconda delle distanze (fino a 2000 km). L’OMEGA utilizza una tecnica simile e, con un’opportuna elaborazione, porta l’errore di posizione attorno a 3 km.

I principali sistemi a breve raggio consentono misure di angolo azimutale, con errore attorno a 5°, tramite un radiogoniometro che riceve l’emissione di un NDB (Non directional beacon) oppure con errore attorno a 1°÷3°, ricevendo il segnale di un VOR (VHF Omni range), emesso con modulazione tale da contenere l’informazione di azimut. Le distanze sono ricavate tramite il distanziometro DME (Distance measuring equipment), che opera misurando il ritardo con cui si ricevono impulsi di radioonde, emessi da bordo, ricevuti e riemessi dal radioaiuto (risponditore) a terra; si hanno errori attorno allo 0,25%.

Il più diffuso sistema di radionavigazione per l’atterraggio è l’ILS (Instrument landing system). Grazie a particolari funzioni d’irradiazione e di modulazione delle onde emesse da una coppia di radioaiuti, si ricevono a bordo due segnali di scostamento in azimut e in elevazione rispetto alla direzione che conduce alla pista; lungo tale sentiero di discesa (tipicamente 3° in elevazione), l’informazione di distanza dall’inizio pista è ottenuta in modo discreto in corrispondenza del passaggio su due o tre radiofari (markers) situati a distanze note (attorno a 0,3, 1 e 10 km). Gli ILS vengono classificati in categorie, in relazione alle prestazioni garantite; nella categoria di maggior rango (CAT IIIC) è consentito l’atterraggio in completa assenza di visibilità. Il più recente sistema di atterraggio basato a terra è il MLS (Microwave landing system); privo del successo commerciale inizialmente previsto a causa dei costi elevati delle infrastrutture a terra e dell’avionica, non solo consente le operazioni in assenza di visibilità, ma permette anche la scelta della traiettoria (anche curvilinea) all’aeromobile. Nella tab. 5 sono riportate le caratteristiche di alcuni apparati di radionavigazione per applicazioni aeronautiche e navali.

Bibliografia

Blefari Melazzi 2005: Blefari Melazzi, Nicola, Internet - architettura, principali protocolli e linee evolutive, Milano,McGraw-Hill, 2005.

Decina, Giacomazzi 2007: Decina, Maurizio - Giacomazzi, Paolo, Il futuro dei protocollo internet, “Mondo digitale”, 22, 2007.

Dunlop 1999: Dunlop, John - Girma, Demessie - Irvine, James, Digital mobile communications and the TETRA system, Chi-chester, Wiley, 1999.

Galati, Gilardini 2000-2001: Galati, Gaspare - Gilardini, Aldo, Tecniche e strumenti per il telerilevamento, I e II, Roma, Consiglio Nazionale delle Ricerche, 2000-2001.

Kaplan, Hegarty 2006: Kaplan, Elliott D. - Hegarty, Christopher J., Understanding GPS, principles and applications, 2. ed., Boston-London, Artech House, 2006.

Kayton, Fried 1997: Kayton, Myron - Fried, Walter R., Avi-onic navigation systems, 2. ed., New York-Chichester, Wiley, 1997.

Maral, Bousquet 1993: Maral, Gérard - Bousquet, Michel, Satellite communications systems, 2. ed., Chichester, Wiley, 1993.

Pattan 1993: Pattan, Bruno, Satellite systems, principles and technologies, Berlin, Springer, 1993.

Piermarini, Vannucchi 2007: Piermarini, Roberto - Vannucchi, Guido, Tecnologie wireless per la larga banda, scenari evolutivi, “Mondo digitale”, 23, 2007.

Saracco 2005: Saracco, Roberto, I prossimi 15 anni dell’ICT, “Mondo digitale”, 16, 2005.

Sklar 2001: Sklar, Bernard, Digital communications, fundamentals and applications, 2. ed., Upper Saddle River, Prentice-Hall, 2001.

Skolnik 2001: Skolnik, Merrill I., Introduction to radar systems, 3. ed., Boston, McGraw-Hill, 2001.